CONSERVATOIRE NATIONAL DES ARTS ET METIERS

PARIS

MĖMOIRE

Présenté en vue d’obtenir le

DIPLÔME D’INGĖNIEUR C.N.A.M

en

INFORMATIQUE

par

Laurent DONGĖ

Réalisation d’un projet de merchandising

Soutenu le jeudi 6 décembre 2007

Jury

Présidente : Isabelle COMYN-WATTIAU, Professeur

Membres : Tatiana AUBONNET, Maître de conférence

Jacky AKOKA, Professeur

Pierre AUDOIN, Chef de service

Pierre ESTIVALET, Merchandiser Senior

Résumé :

Aujourd’hui, afin d’être plus compétitifs, les groupes de distribution ont besoin de se doter d’outils d’optimisation de la présentation des produits sur leurs surfaces de vente. C’est ce que permet l’application Merchandising. On gagne en productivité en automatisant les tâches manuelles et en simplifiant les outils.

Pour rester souple par rapport à l’utilisation d’une solution propriétaire, nous avons fait le choix de gérer les notions « métier » propres à l’entreprise dans une solution spécifique.

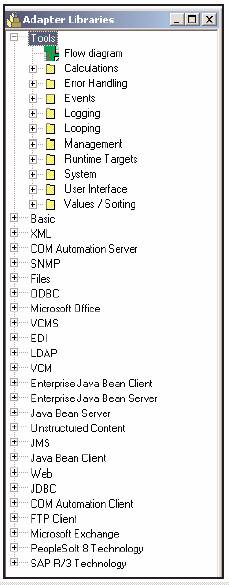

Cette application a dû être intégrée dans un Système d’Information d’entreprise très hétérogène. L’utilisation d’un ETL permet de réduire la complexité du système en définissant un cadre de développement précis et en masquant les différentes implémentations techniques.

Plus on en élargit l’emploi, plus la complexité du système diminue. Il nécessite cependant certains outils annexes pour répondre complètement aux besoins.

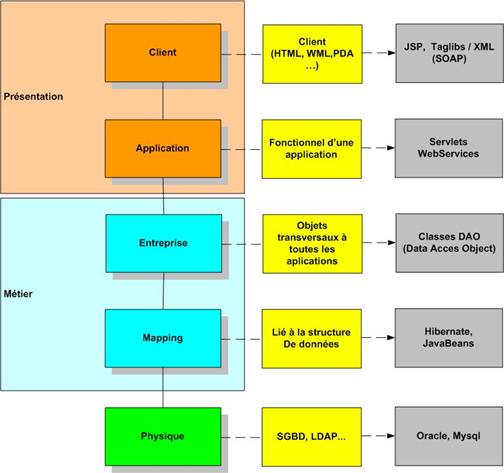

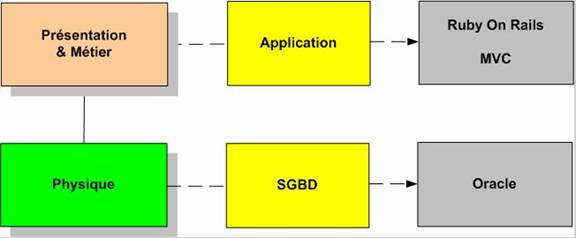

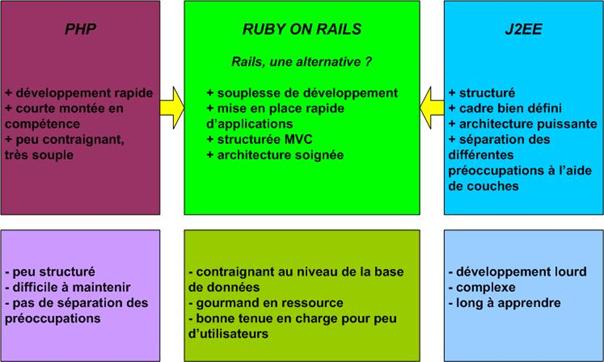

D’autre part, nous avons utilisé J2EE pour implémenter les interfaces WEB. C’est une architecture qui répond à nos besoins d’IHM. Elle permet de concevoir des applications structurées, maintenables, mais avec l’inconvénient d’engendrer des coûts de développement importants.

L’architecture WEB utilisée n’est pas propriétaire mais basée sur des produits Open Source. Elle présente un avantage financier certain du fait de l’absence de dépenses liées aux licences.

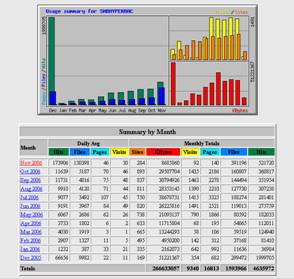

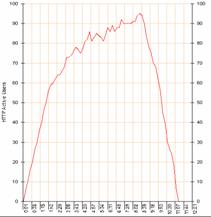

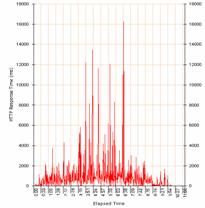

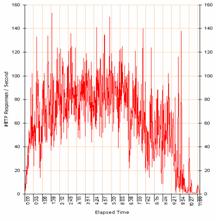

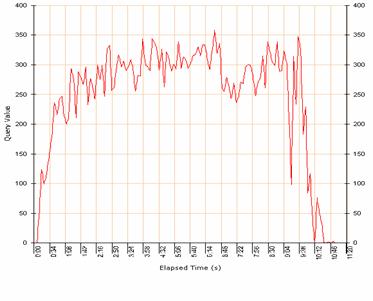

Enfin, des séries de tests de montée en charge ont permis de valider la qualité de services rendus aux utilisateurs.

La mise en œuvre de l’application répond aux objectifs essentiels. Il est cependant nécessaire de mieux répondre aux besoins de supervision, de reporting et de gestion de la qualité des données.

Mots-clés :

ETL, conception d’application J2EE, architecture, Open Source, tests

Summary :

Today, in order to be more competitive, distribution groups need tools to optimize product presentation in their stores. The Merchandising application allows this. With the automatisation of manual tasks and the use of simple tools, productivity has been increased.

To remain flexible compared to the use of an owner solution, we made the choice to manage the concepts with a solution specific to the company.

This application has been integrated into a heterogeneous information system with an ETL. The ETL reduces the system complexity, as it defines a precise development framework and it hides the various technical implementations.

The more the ETL is used, the more the system complexity decreases. However, ETL requires additional tools to satisfy all our needs.

In addition, we use J2EE to implement the WEB interfaces. It is an architecture which meets our HMI needs. It allows the development of structured applications, easy to support, but the development costs generated are very high.

The WEB architecture used is based on Open Source products. There is a financial advantage in using these products as there is no licence to pay.

Stress Tests have allowed the validation of the quality of services given to the users.

The implementation of the application has satisfied the essential needs. However, some evolutions are needed in order to have tools capable of answering requests of supervision, reporting and management of data quality.

Keywords :

ETL, J2EE application design, architecture, Open Source, tests

REMERCIEMENTS

J’ai effectué mon « stage » au sein du service Reporting et Pilotage du département administratif de la Direction de l’informatique du Groupe MONOPRIX, sous la responsabilité de Jean-François Lemaire, chef de service et en collaboration avec Pierre Audoin, responsable du Merchandising PGC. Ce « stage » a débuté en septembre 2004.

Suite à la réorganisation de la Direction de l’informatique, en début 2007, le projet Merchandising est désormais rattaché au service référentiel du département Marchandise dont la responsable est Isabelle Renoncet.

A ma demande, j’ai été transféré dans l’équipe d’Isabelle Renoncet à partir du premier avril 2007 pour continuer à piloter le projet.

Ce mémoire n’aurait pu voir le jour sans le soutien de mes professeurs du CNAM, de mes collègues, de mes amis et de ma famille.

Parmi toutes ces personnes, je tiens à exprimer mes remerciements à Monsieur Jacky Akoka à qui je dois d’avoir pu présenter ce mémoire après neuf années de cours du soir.

Je remercie tout particulièrement Monsieur Pierre Audoin pour son aide précieuse et son soutien sans faille tout au long du projet, ainsi que les ingénieurs d’étude qui ont travaillé sur le projet.

Je remercie également Madame Isabelle Renoncet pour la compréhension dont elle a fait preuve dès mon arrivée dans son service.

Un travail de si longue haleine suppose le soutien des proches. Je remercie mon épouse Xiao ping pour le soutien qu’elle m’a toujours apporté et sa patience. Merci également à Léona et Roland pour leur encouragement.

1.4. Les étapes importantes du projet

2. Présentation des méthodologies, technologies et concepts utilisés

2.1. Gestion et management de projet

2.2. Les modèles et les méthodes

2.3. Management des ressources humaines

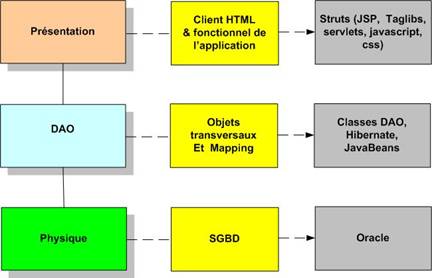

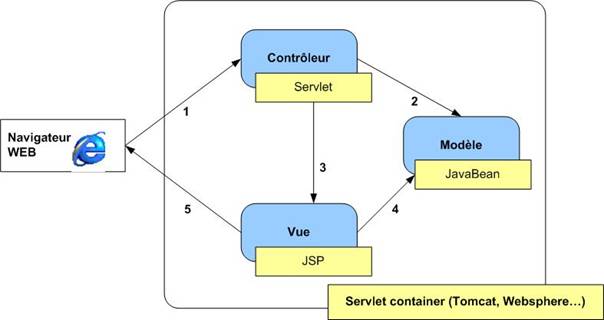

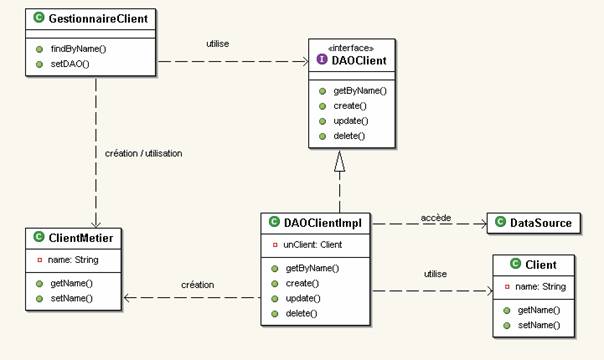

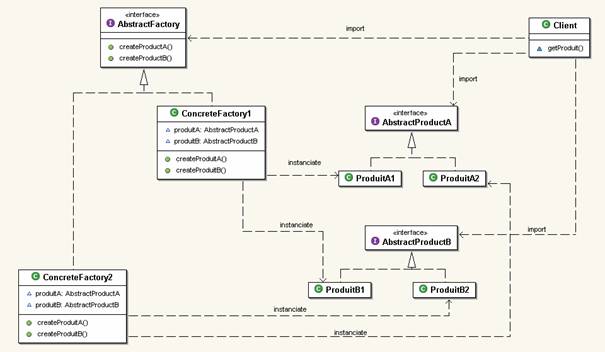

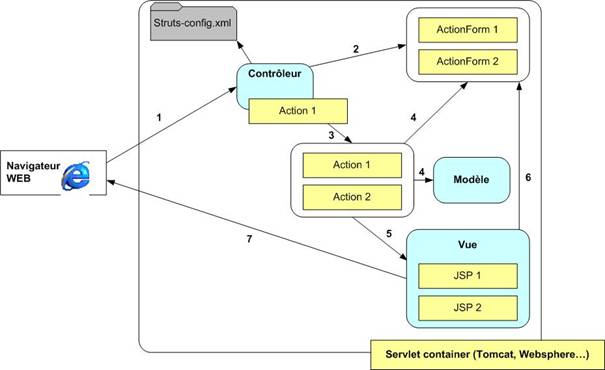

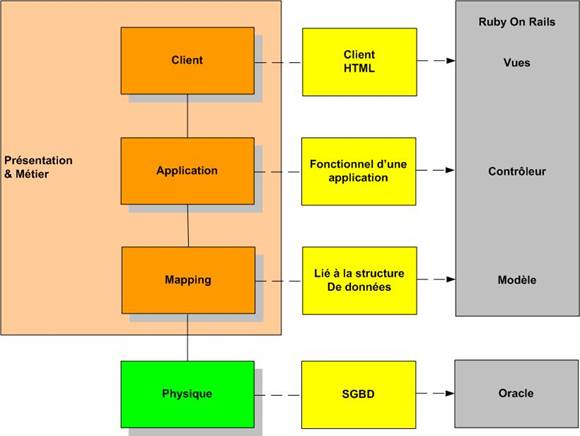

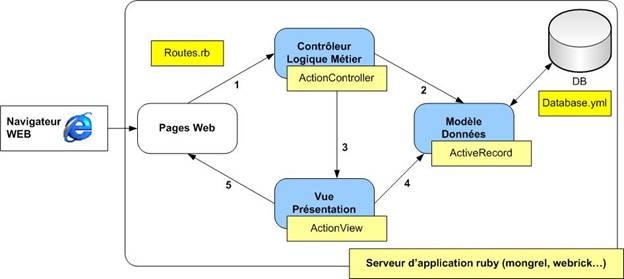

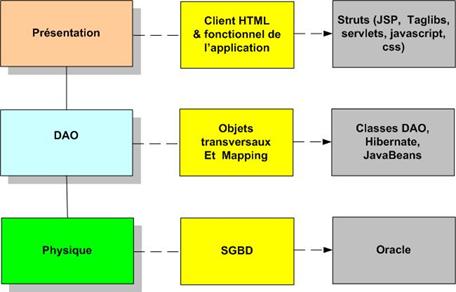

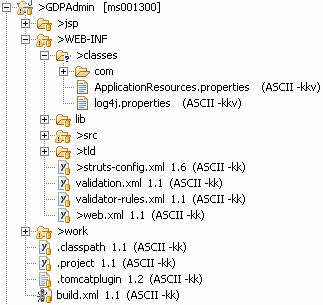

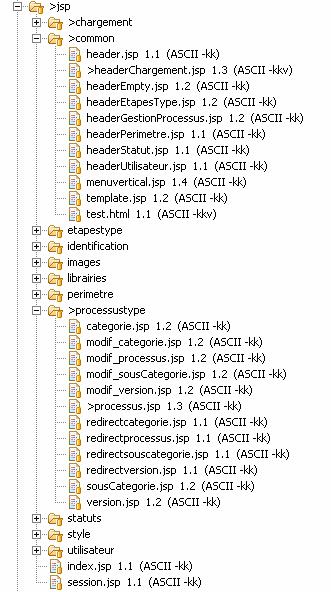

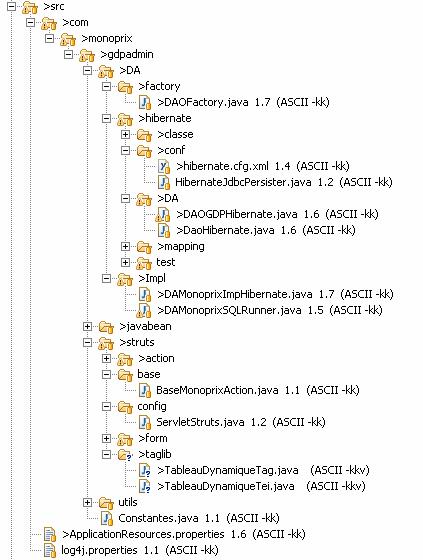

2.5. Organiser une application J2EE

3. Mise en œuvre de l’application merchandising

3.1. Présentation de l’application merchandising

3.2. Gestion du projet merchandising

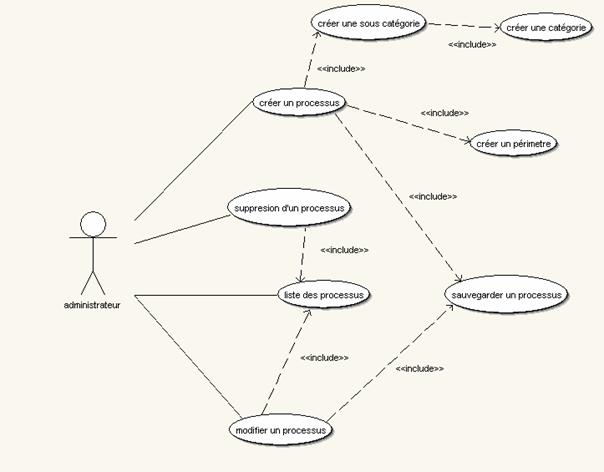

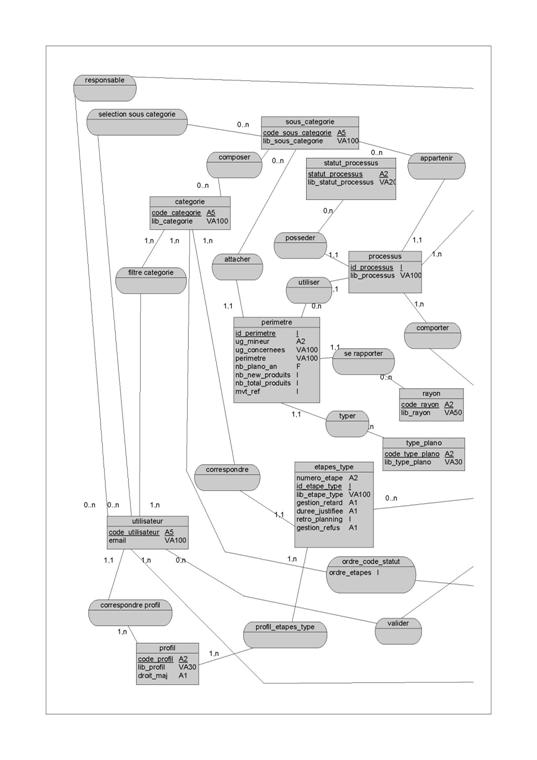

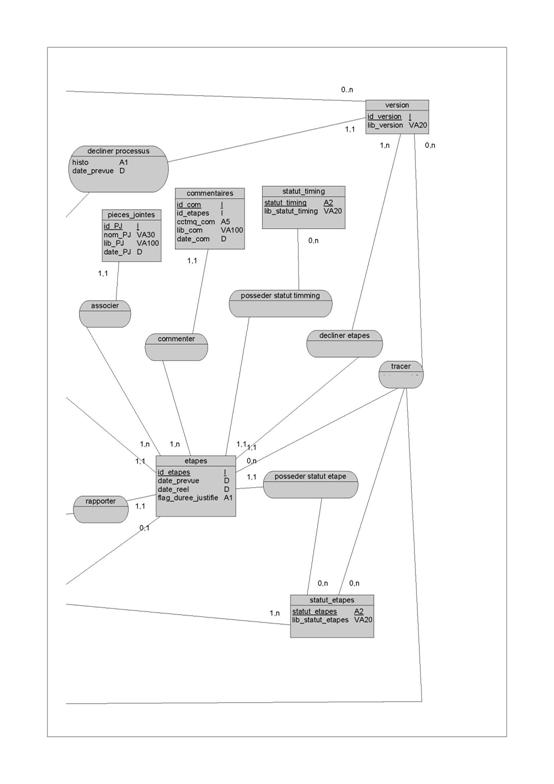

3.3. Illustration de la démarche

3.4. Intégration dans le Système d’Information existant.

3.5. Mise en œuvre de l’architecture J2EE

3.6. Réalisation des tests de montée en charge

4.3. Bilan Architecture Web J2EE

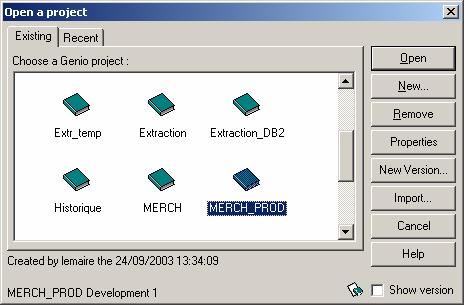

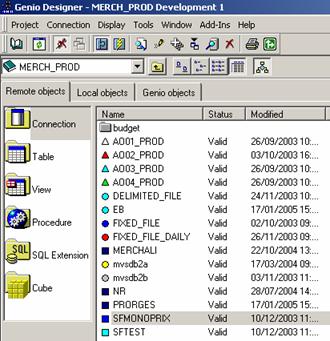

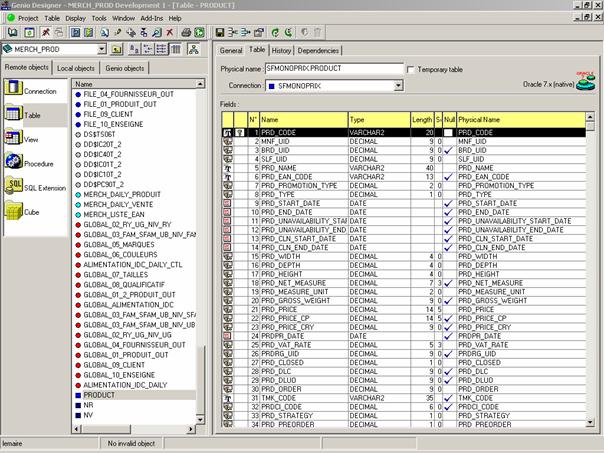

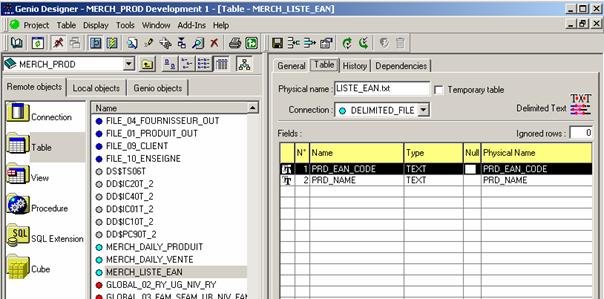

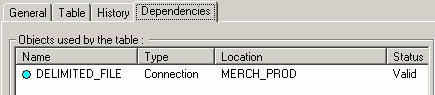

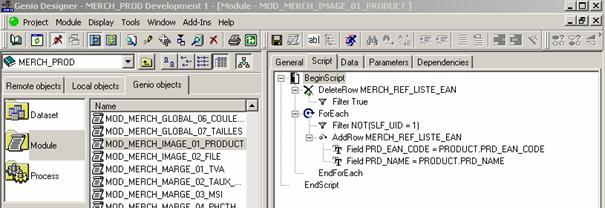

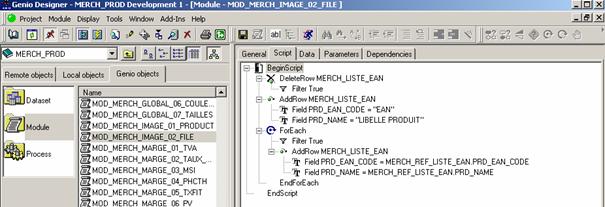

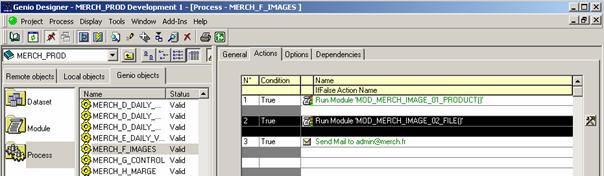

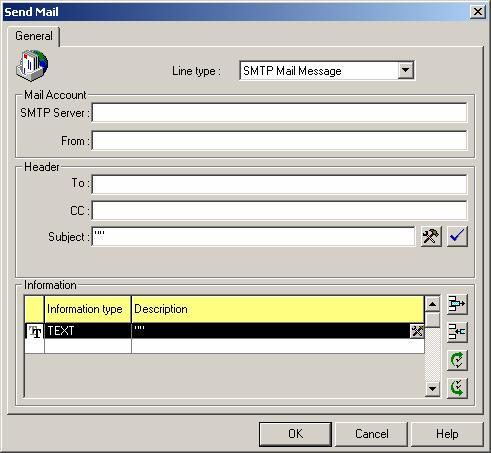

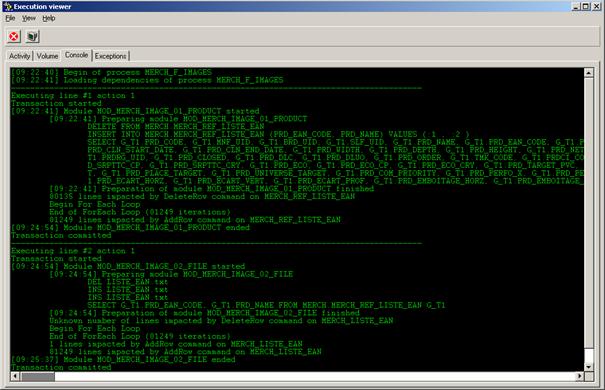

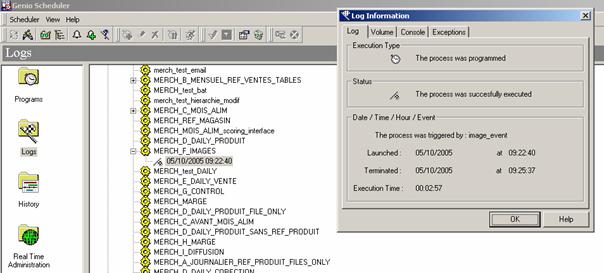

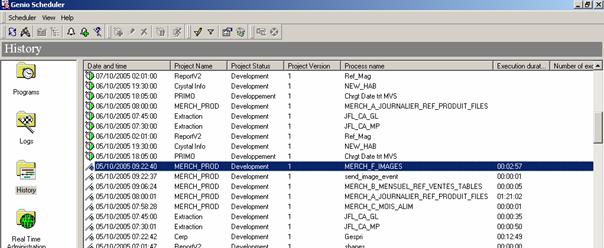

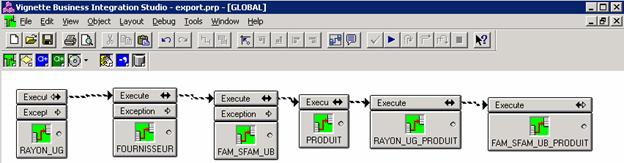

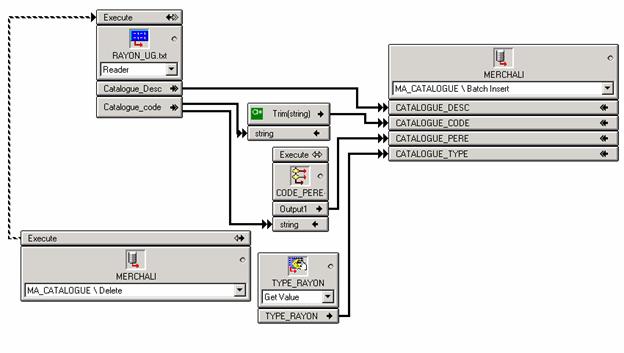

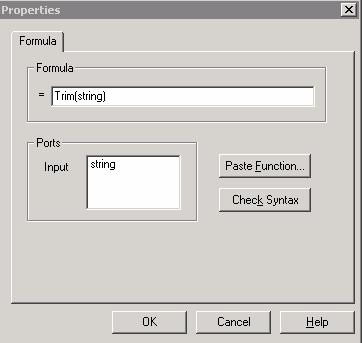

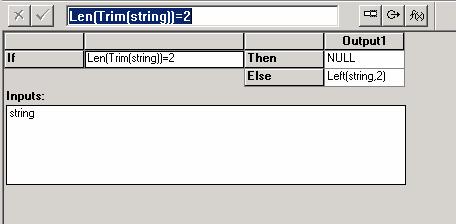

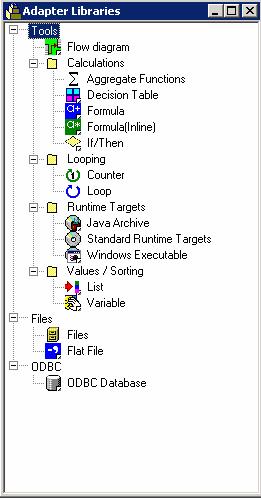

Annexe A : Exemples de développement ETL GENIO

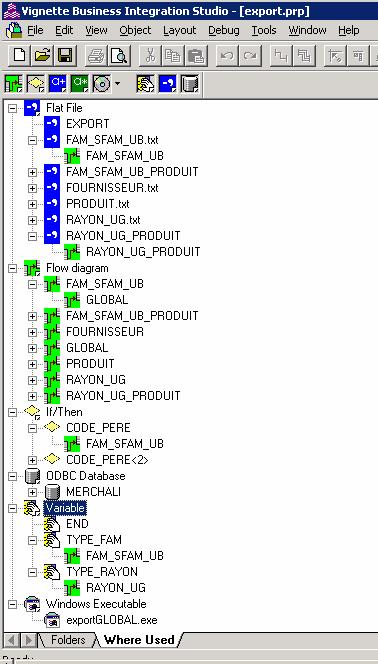

Annexe B : Exemple de développement VBIS.

Annexe C : Exemple de développement J2EE.

Annexe D : Résultats des tests de montée en charge

Annexe E : Publications dans Monop Infos, magazine interne, entre octobre 2005 et avril 2007

Annexe G : Versions des logiciels

Annexe H : Exemples de dossier de préconisations

Annexe I : Illustration correspondant à un plan magasin

Annexe J : Cartographie de l’application merchandising

Annexe K : Liste des tables des bases de données de l’application spécifique

Annexe L : Scoring correspondant au choix du logiciel

Annexe M : Cartographie macroscopique du Système d’Information de Monoprix

Annexe N : Présentation des fonctionnalités principales du progiciel de KLEE

Annexe O : Présentation des écrans de l’application spécifique

Annexe P : MPD

Annexe Q : RAILS - contrôleur RO et CRUD CLASSIQUE

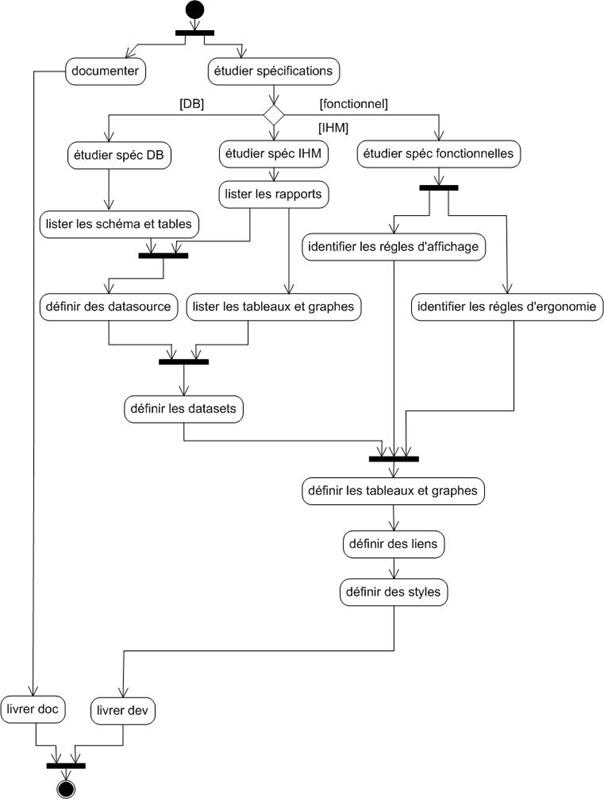

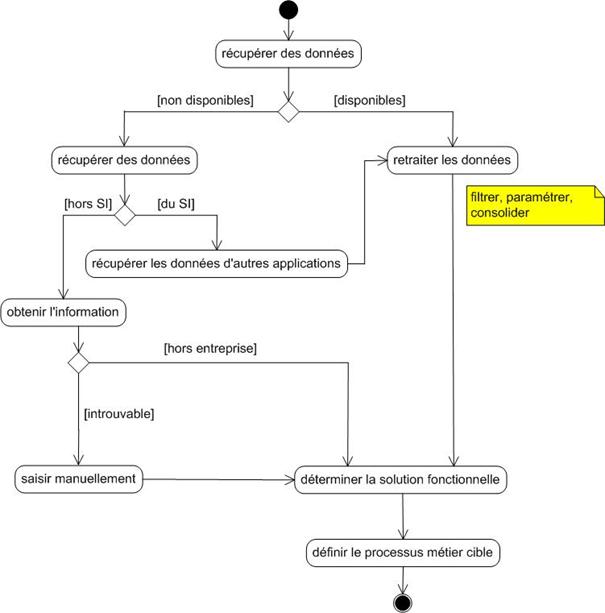

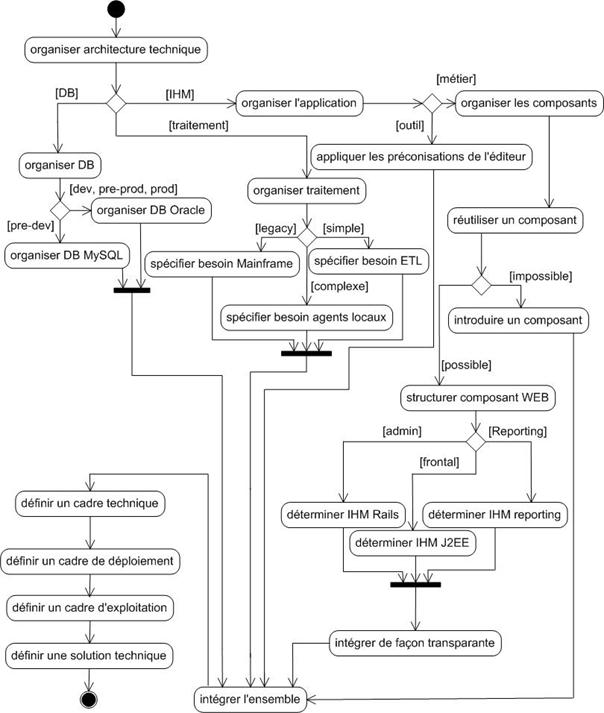

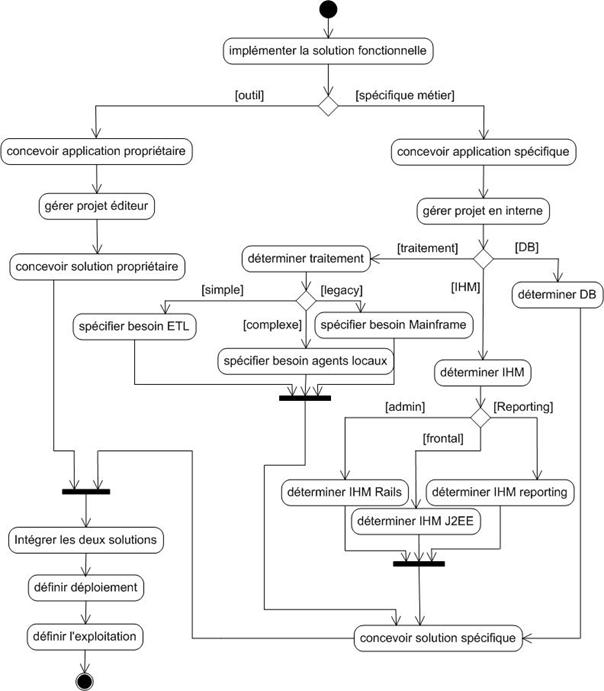

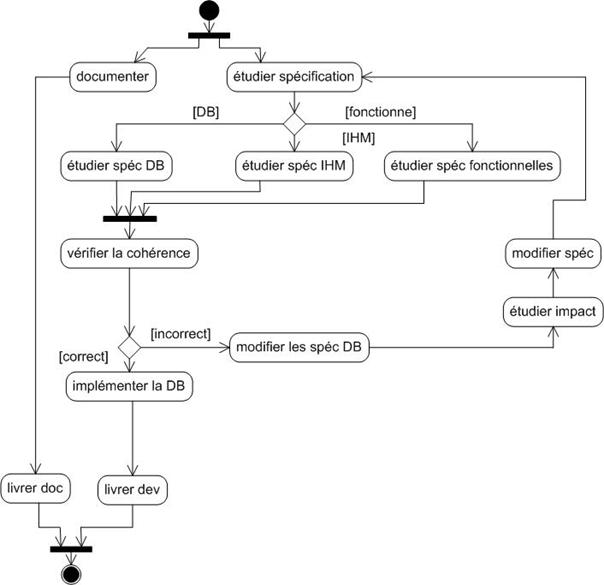

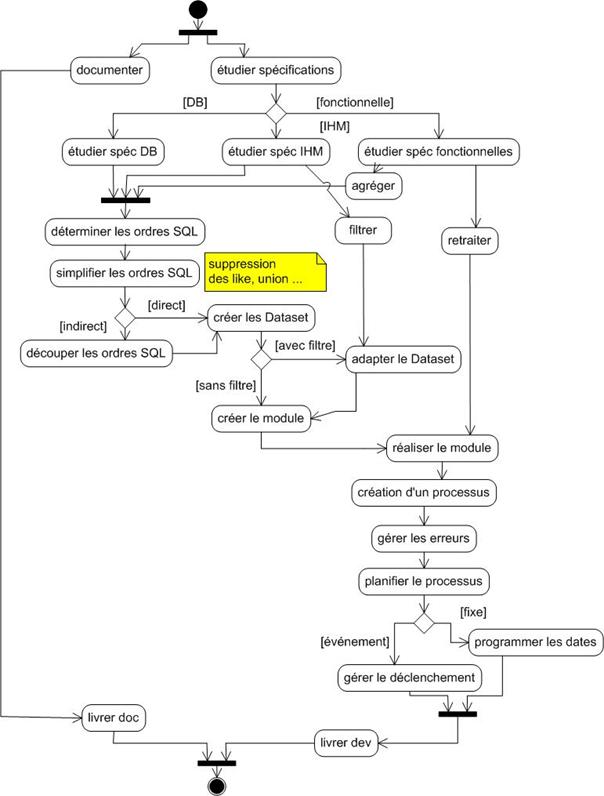

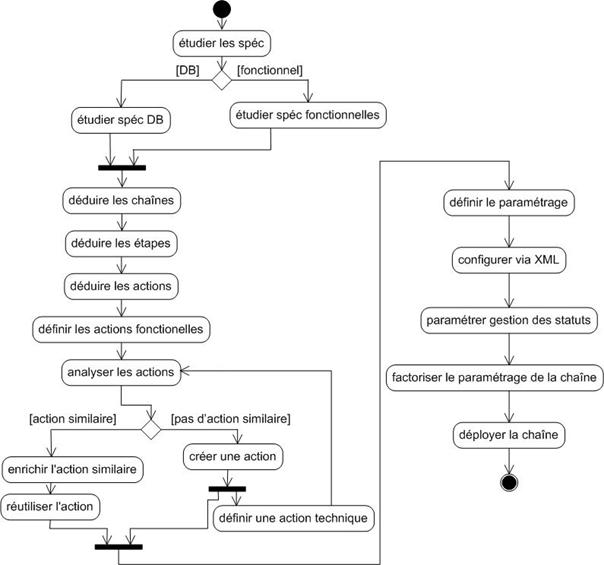

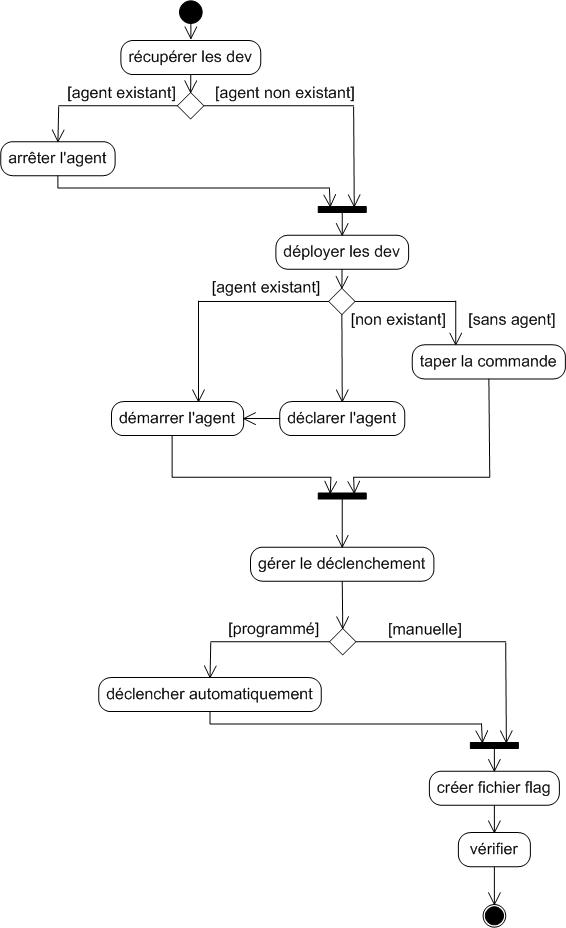

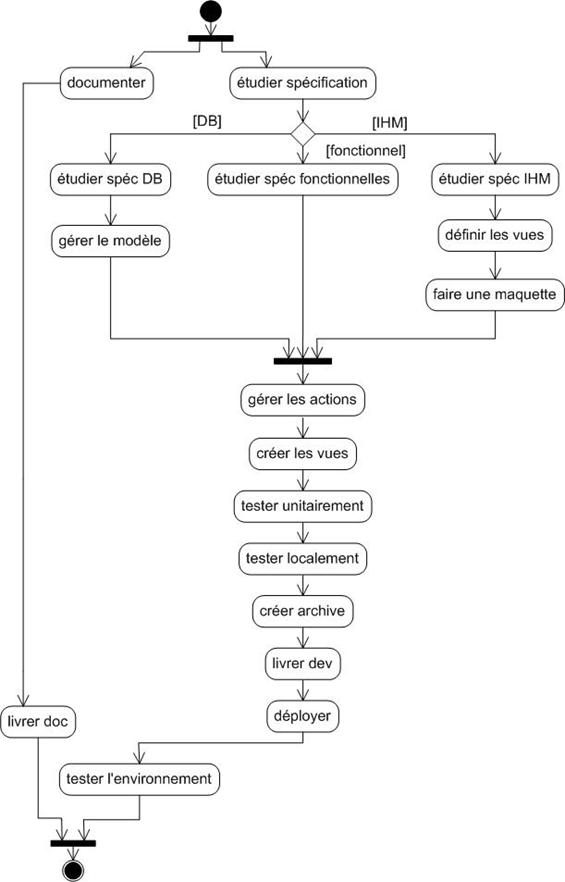

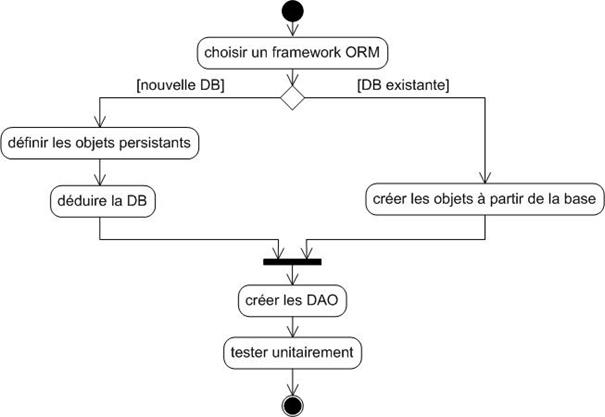

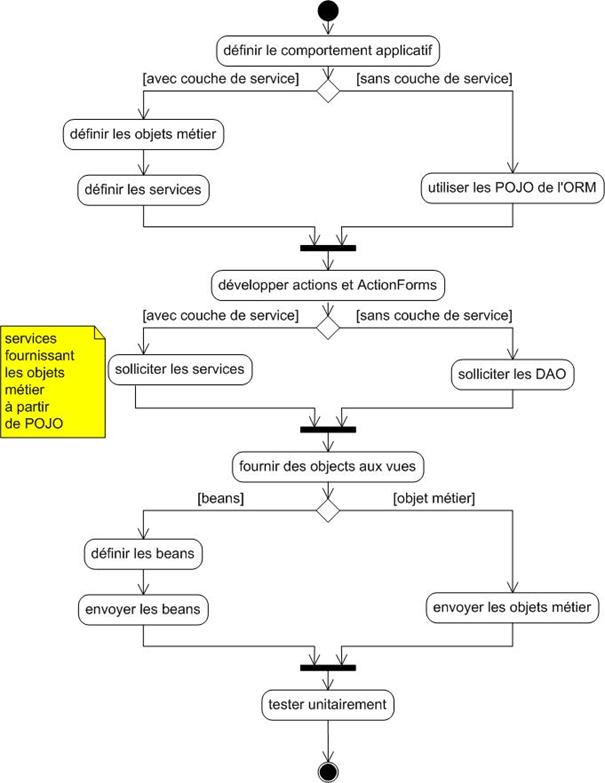

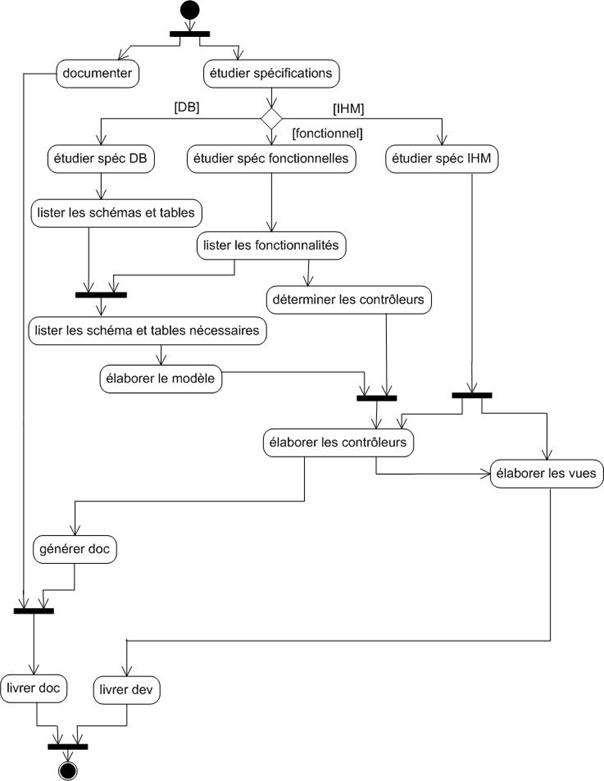

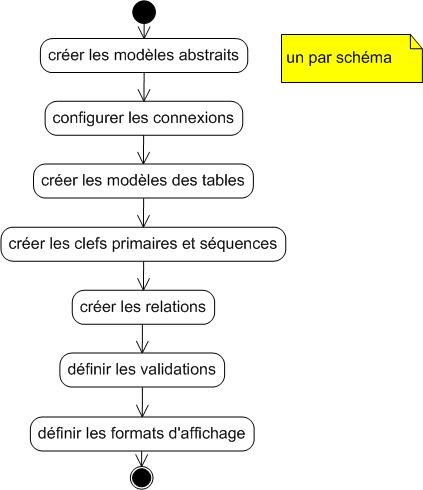

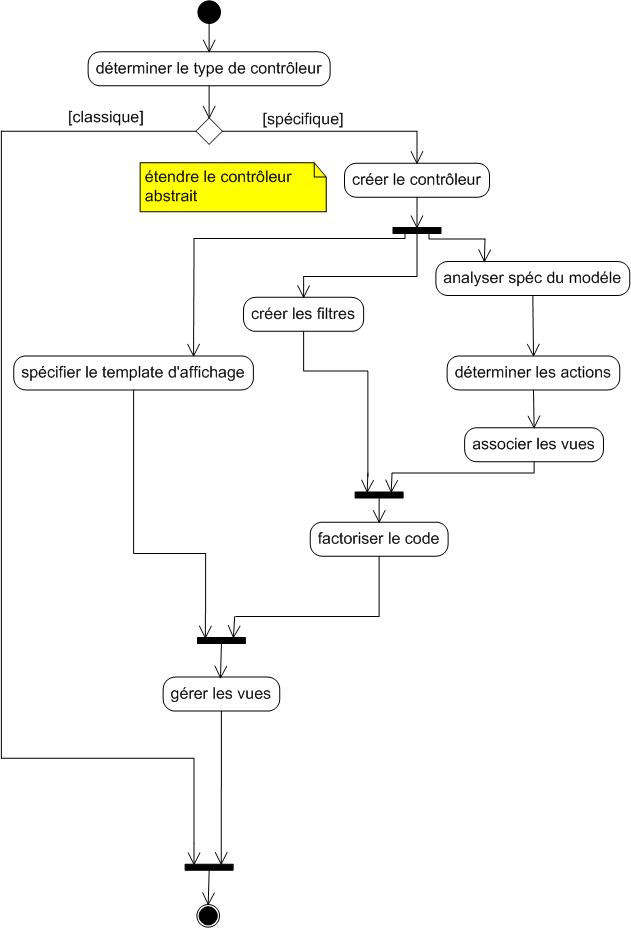

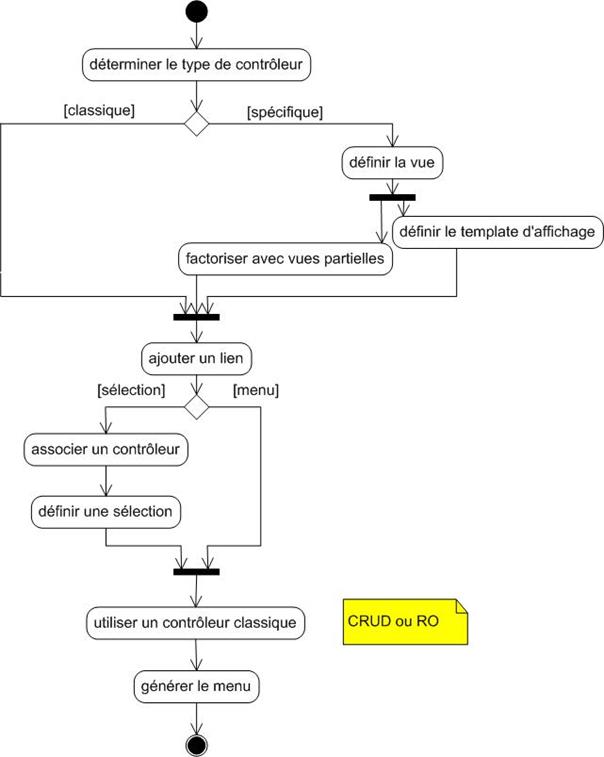

Annexe R : Processus du projet – diagrammes d’activité

Introduction

Aujourd’hui, de nombreuses entreprises choisissent les meilleurs outils informatiques pour répondre à leurs besoins afin d’être le plus compétitif possible. Elles se dotent ainsi d’ERP ( Entreprise Resource Planning ) ou de suites logicielles spécialisées. En suivant cette démarche, leurs systèmes d’information gagnent en complexité. Choisir la meilleure solution pour répondre à chacun de ses besoins multiplie le nombre de technologies et de standards utilisés au sein de l’entreprise.

Nous allons nous intéresser aux problématiques liées à cette démarche d’entreprise, à travers la mise en œuvre de la suite logicielle SMART Office au sein du groupe de distribution de proximité MONOPRIX. Cette suite permet d’élaborer des dossiers de merchandising fournissant des préconisations de mise en rayon des produits à l’attention des magasins.

Dans un premier temps seront présentés le projet, les grands principes du domaine fonctionnel lié au merchandising, les raisons de l’origine du projet, ses contraintes, ainsi que les étapes importantes du projet, l’étape pour arrêter un choix sur une offre logicielle particulière.

Une présentation des méthodologies, technologies et concepts utilisés sera suivie par l’exposé de la mise en œuvre de l’application merchandising. La démarche pour mener à bien le projet sera précisée.

Après avoir choisi la suite logicielle qui semble correspondre le mieux à nos besoins, il reste à l’intégrer dans le Système d’Information existant. Il faut alors récolter l’information nécessaire au bon fonctionnement de la suite logicielle, puis fournir les éléments permettant de diffuser les dossiers de préconisations de mise en rayon aux magasins. Après une présentation du Système d’Information existant, nous nous attacherons aux moyens d’intégrer différentes applications d’entreprise, en particulier à l’aide d’ETL ( Extract Transform and Load) et d’EAI (Entreprise Application Integration), dont le point fort est de faire cohabiter des systèmes hétérogènes.

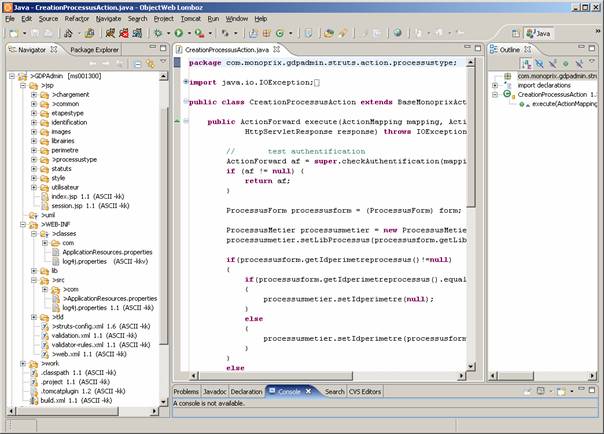

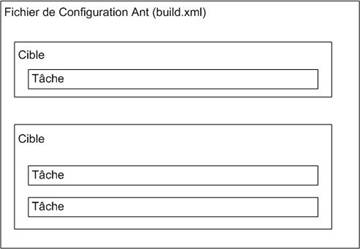

Mais ces produits ne suffisent pas à eux seuls à fournir une solution applicative complète, il faut également se doter d’interfaces, afin de pouvoir administrer l’intégration des informations récoltées, de diffuser les documents de préconisations réalisés et de suivre l’élaboration des dossiers de préconisations. Il est alors nécessaire d’organiser son application [JOU05a] et de choisir des outils de développement. Nous avions une volonté forte d’utiliser des outils permettant de rendre le code plus lisible et ainsi de simplifier la maintenance de ce dernier afin de ne pas se retrouver avec des développements de type « spaghetti ».

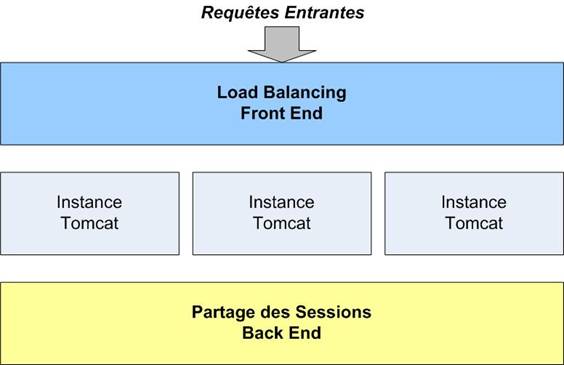

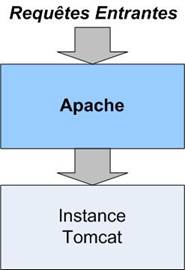

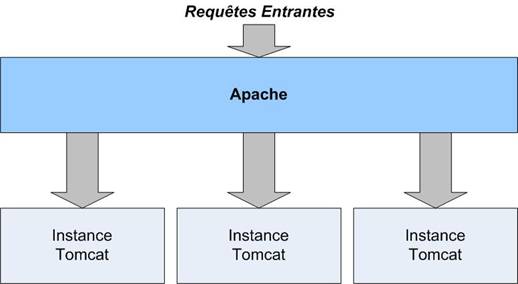

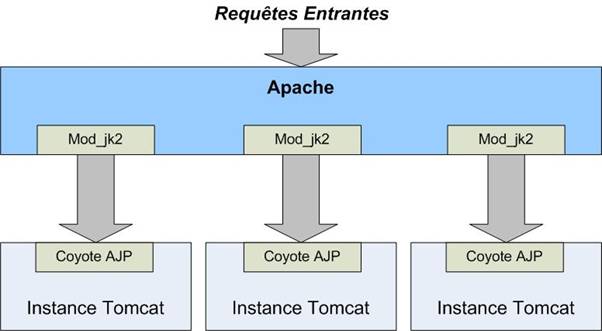

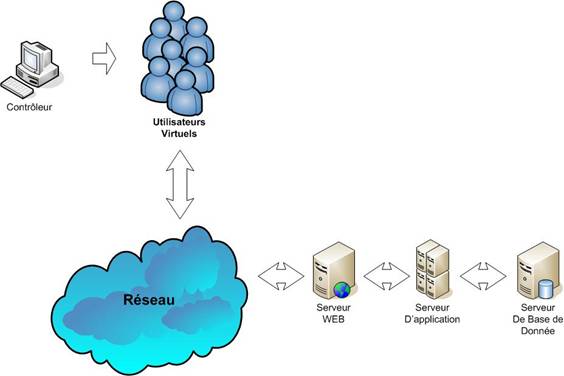

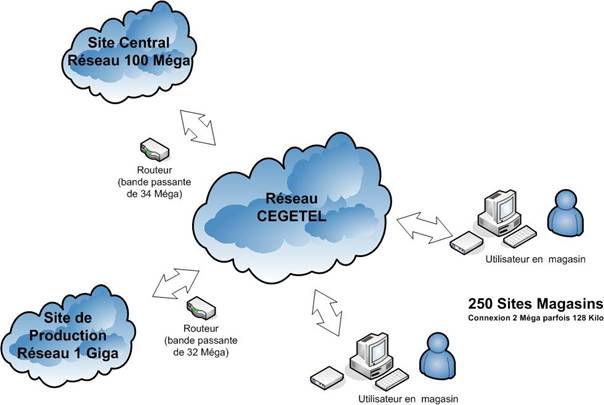

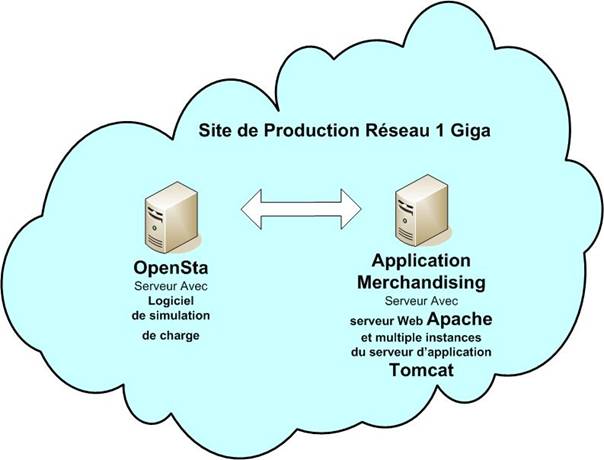

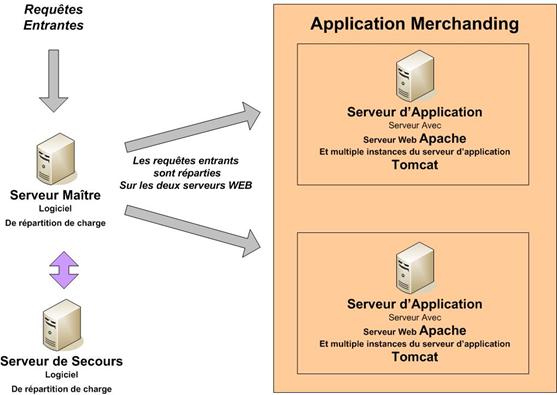

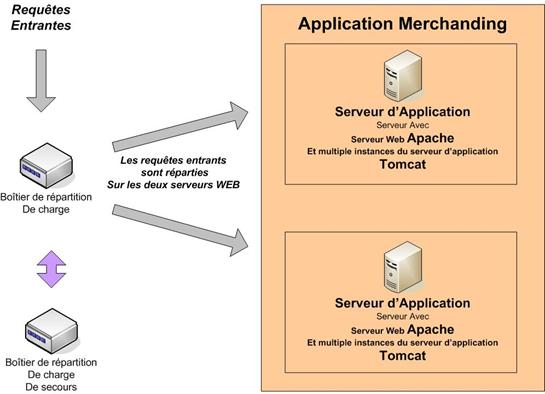

Se pose ensuite la question de l’architecture à mettre en place, dans laquelle nous allons déployer les développements réalisés. En fonction du nombre d’utilisateurs que nous souhaitons supporter, de la lourdeur des développements, du temps de réponse attendu, du niveau de sécurité désiré et de la tolérance de panne exigée, quelle architecture devons-nous mettre en œuvre ? Nous présenterons alors la solution Open Source basée sur Apache et Tomcat.

Enfin, comment pouvons-nous savoir que les développements réalisés et déployés dans l’architecture, ainsi que cette dernière, vont vraiment offrir la qualité de service attendu ? La réalisation de stress tests permettra de répondre à cette question. Nous présenterons alors ce que sont des stress tests, leur utilité, des offres du marché permettant de les réaliser, la démarche utilisée et leurs limites.

1. Le projet

Objectif

Le projet a pour but de renouveler l’application de merchandising PGC (Produit Grande Consommation). Cette application est utilisée au sein de l’enseigne de distribution de proximité MONOPRIX par une cellule merchandising de 10 personnes.

Elle permet d’élaborer des dossiers de préconisations de mise en rayon à destination des 250 magasins du groupe.

En se dotant d’un outil plus perfectionné, l’entreprise souhaite réduire les coûts associés aux processus « métier » liés à l’élaboration des dossiers de préconisations. Elle compte ainsi augmenter la productivité en limitant les interactions humaines et en raccourcissant la durée de ces processus.

Les acteurs

L’élaboration des dossiers de préconisations implique de nombreux acteurs. Elle est faite par la cellule merchandising en collaboration avec les bureaux d’achat, le marketing, les fournisseurs et la direction des ventes.

En amont, l’achat élabore les collections. Le marketing fournit une stratégie. Les fournisseurs font des propositions dans leurs spécialités.

En aval, la cellule merchandising organise la mise en scène des produits et la vente exploite les dossiers de préconisations.

Enfin, les merchandisers travaillent étroitement avec les fournisseurs qui procurent les visuels et les caractéristiques de leurs produits.

Contexte

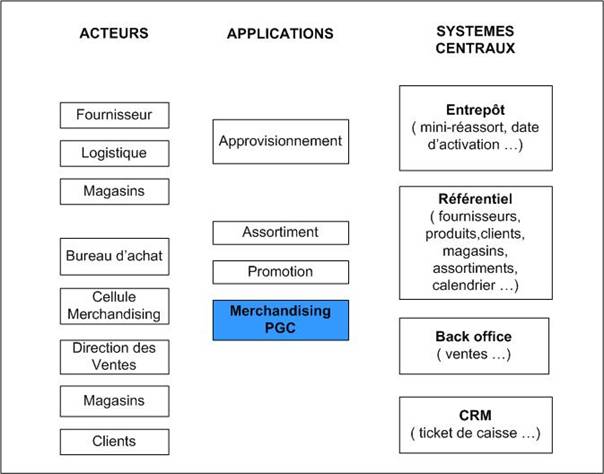

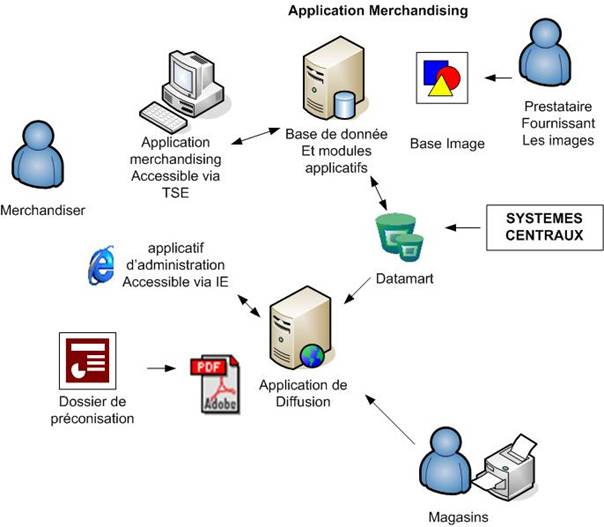

Le schéma ci-dessous positionne l’application de merchandising par rapport aux principaux acteurs, applications et systèmes centraux auxquels elle se rapporte.

Figure 1 : Vision Globale Acteurs, Applications, Systèmes centraux

Sujet du mémoire

Le sujet de ce mémoire est la « réalisation d’un projet de merchandising ». Le merchandising n’est pas le sujet principal de ce mémoire. Nous allons nous intéresser plutôt aux aspects techniques qu’aux aspects fonctionnels et à la démarche qui a été suivie pour mener à bien ce projet.

Les problématiques auxquelles nous allons nous attacher sont :

· La gestion et le management de projet

· La façon d’intégrer une suite logicielle au sein d’un Système d’Information hétérogène existant.

· Le choix de technologies WEB et d’outils de développement. Ainsi que les raisons de ce choix.

· Le choix d’une architecture WEB et la validation de cette architecture.

Le projet merchandising va permettre d’illustrer ces quatre problématiques. L’objectif n’est pas d’exposer dans ses moindres détails les problématiques liées à ce projet mais plutôt de se servir de ce cas concret pour apporter des réponses à ces problématiques.

Le but de ce mémoire n’est pas non plus de traiter de ces sujets de façon exhaustive, mais de se concentrer sur les points réellement abordés lors du projet et qui ont permis de le mener à bien et de répondre de façon satisfaisante aux besoins des utilisateurs. Compte tenu des délais et des impératifs du projet, il est difficilement possible de maîtriser pleinement l’ensemble des technologies et des logiciels qui vont être utilisés lors de ce projet.

L’important est de saisir l’essentiel de ce qu’apporte chacun des outils utilisés et de s’en servir le plus simplement possible afin que le projet reste évolutif et facilement maintenable.

1.1. Le merchandising

Présentation

Le merchandising correspond à l’ensemble des techniques visant à optimiser la répartition et la présentation des produits en magasin afin d’optimiser la rentabilité et le trafic et de contribuer à l’expression de l’image de l’enseigne.

Cette définition paraît très simple, mais derrière cette simplicité se cache un certain niveau de complexité.

En effet, pour arriver à élaborer des dossiers de préconisations de mise en rayons à destination des magasins, le merchandiser a besoin de nombreuses informations relatives :

- aux produits : prix, dimensions, nomenclature, caractéristiques, images des produits

- aux points de ventes : mobilier, capacité des linéaires, assortiments des produits correspondant au point de vente, historiques de vente du produit, colisage de livraison, périodicité de livraison

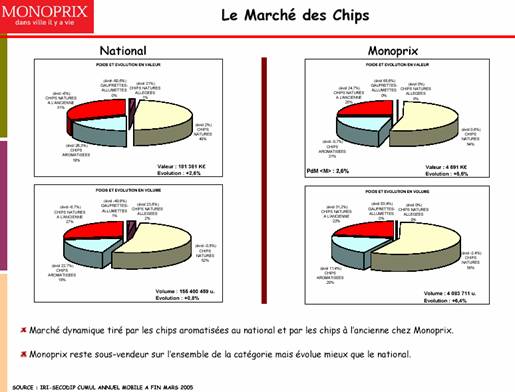

- à la politique de l’entreprise, l’état du marché national et son évolution

- d’un modèle de vente : écoulement des ventes sur la semaine

Le travail du merchandiser consiste, à partir de ces informations et en partenariat avec les bureaux d’achat de l’entreprise et la direction des ventes, à proposer une répartition des produits en magasin afin de répondre pleinement aux ventes et à ne pas avoir de rupture de produit en rayon. Il va faire des préconisations sur le nombre de facings à accorder à un produit dans le linéaire du magasin et sur son emplacement. Ces préconisations se font à partir de données quantitatives dont nous avons fait une liste non exhaustive ci dessus et qui vont être extraites du Système d’Information de l’entreprise mais également de notions qualitatives telles que les couleurs des visuels correspondant aux différents produits. Le merchandiser va par exemple chercher à obtenir le meilleur rendu visuel afin de rendre la répartition des produits la plus agréable possible pour le consommateur. L’aspect visuel est donc une composante importante de l’élaboration des dossiers de préconisations.

Dossiers de préconisations

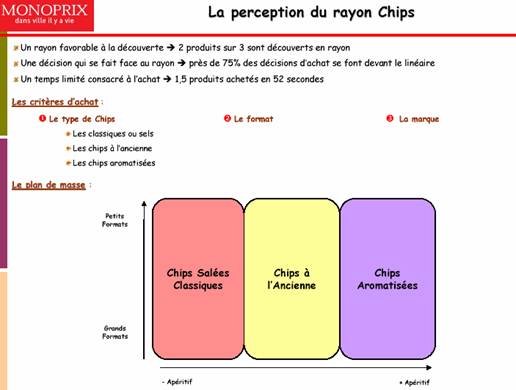

Les dossiers de préconisations à destination des magasins présentent toujours le même type de structure :

- une page de garde (Figure 2)

- un argumentaire (Figure 3)

- une présentation du marché national et de l’enseigne, l’évolution du marché

- des plans de masse (Figure 4)

- les planogrammes en couleurs avec les visuels des produits (Figure 5). Il existe plusieurs planogrammes en fonction du linéaire du magasin. Un planogramme correspond à une représentation graphique des mobiliers en magasin sur lesquels on a positionné des produits. Les produits sont facilement identifiables à l’aide de photos les représentant.

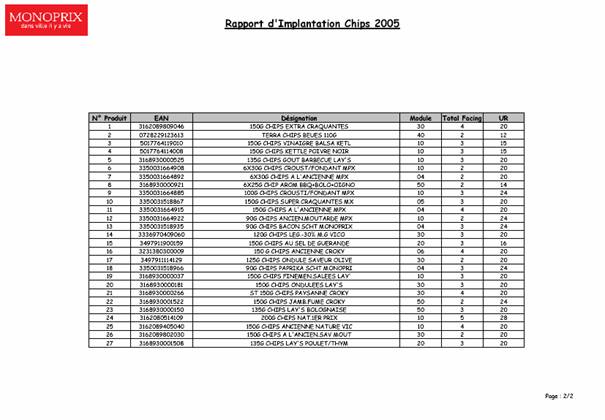

- Liste des produits du planogramme (Figure 6): numéro de produit sur le planogramme, ean du produit, désignation, nombre total de facing, colisage de réassortiment du produit

(correspond à la quantité minimale que l’on peut livrer au magasin).

Le magasin, à l’aide de ces dossiers, optimise de manière rapide la rentabilité de son point de vente sans avoir à faire des analyses complexes et fastidieuses. En effet, ces dossiers sont le fruit d’une analyse conjointe du merchandising, des bureaux d’achats et de la direction des ventes qui tient compte de la capacité des linéaires, de la rotation des stocks et des nouveaux assortiments des produits. Ces dossiers facilitent donc le travail des magasins mais permettent également d’avoir une offre homogène sur l’ensemble des points de vente de l’enseigne. Ils facilitent donc la mise en place de la politique de marketing de l’entreprise.

Figure 5 : Exemple de planogramme

Figure 6 : Liste des produits du planogramme

D’autres exemples de dossiers sont présents dans l’Annexe H.

1.2. Pourquoi ce projet ?

La solution existante.

L’outil existant utilisé par les marchandisers est une vieille version de l’outil SPACEMAN de la société Nielsen qui se compose d’une application autonome installée sur chacun des postes utilisateurs.

Les merchandisers alimentent cette application à l’aide de fichiers au format EXCEL ou TXT (texte).

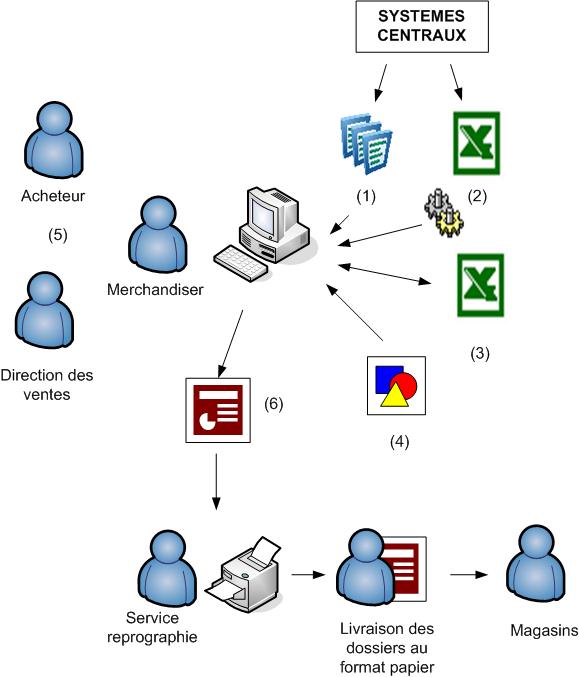

Le processus « métier » d’élaboration utilisé pour élaborer les dossiers de préconisations à l’attention des magasins est le suivant (Figure 7) :

(1) Les informations relatives aux produits et aux ventes sont obtenues à l’aide de BI Query anciennement nommé GQL qui est un requêteur du marché. Les données sont extraites sous la forme de fichier EXCEL.

(2) Les classements des magasins par chiffre d’affaire par périmètre de produits sont extraits à partir du produit Arthur Décision de Comshare. Cette solution repose sur une base Oracle. Elle permet entre autres d’avoir une vision multidimensionnelle des ventes selon les axes produits, magasins, temps et manifestations (les campagnes promotionnelles telles que Noël, Halloween sont des manifestations). Ces classements sont utilisés pour constituer des groupes de magasins qui représentent au mieux le parc de points de vente. Il est en effet impossible de faire l’ensemble des dossiers de préconisations pour chacun des magasins. Il faudrait 2 merchandisers par magasin pour mettre à jour ces dossiers une fois par an, ce qui n’est pas envisageable (la cellule merchandising ne comporte que 10 personnes et il y a 250 magasins). Le merchandiser doit effectuer de nombreuses manipulations sur les classements des magasins et les ventes correspondant aux produits afin de pouvoir utiliser ces informations dans l’application et réaliser les planogrammes.

(3) Un référentiel des différents périmètres de planogrammes et des linéaires associés est géré à l’aide de fichiers au format EXCEL.

(4) Le merchandiser a également besoin des visuels correspondant à son périmètre de produit. S’il lui manque des visuels, il doit lui-même prendre les photos manquantes des produits. Les photos sont enregistrées sur chacun des postes des merchandisers et ne concernent que leur périmètre.

(5) Le merchandiser peut alors se consacrer à l’élaboration des planogrammes et des dossiers en collaboration avec les bureaux d’achat et la direction des ventes.

(6) Le dossier une fois terminé est envoyé à la reprographie qui va en tirer un exemplaire papier pour chacun des magasins. Un exemplaire de chaque dossier est livré en magasin sans tenir compte du fait que le magasin est concerné par tout ou partie du dossier de préconisations : on envoie tout à tout le monde.

Figure 7 : L’outil d’élaboration existant

Les axes d’optimisation

Au vu de ce processus « métier », il est possible d’identifier un certain nombre d’axes d’optimisation.

On peut réduire les coûts liés à ce processus d’élaboration des dossiers de préconisations, en minimisant les interventions manuelles effectuées par les merchandisers. Cela passe par l’automatisation systématique des procédures manuelles qui peuvent l’être.

La centralisation de l’information relative aux planogrammes dans une base de données, la mise en place d’un référentiel image unique et pas de déploiement sur les postes clients de l’application ou un déploiement minimaliste permettent de simplifier et de minimiser les tâches d’administration.

Le choix d’une solution logicielle possédant une interface simple et conviviale diminue la durée de montée en compétence des merchandisers.

Si, de plus, cette solution répond à de nouveaux besoins non couverts par la solution actuelle tels que l’élaboration de dossiers de préconisations pour les surgelés qui sont présentés dans des meubles spécifiques, il est alors possible d’élargir les périmètres concernés par les dossiers de préconisations.

Le fait de souscrire un abonnement images auprès d’une société extérieure pour les périmètres nouvellement traités évite aux merchandisers de prendre eux-même en photo les produits pour lesquels on ne possède pas de visuel.

L’abandon de l’impression papier pour la diffusion des dossiers planogrammes au profit d’une diffusion au format PDF permet de ne plus imprimer et livrer des dossiers aux magasins qui ne sont pas concernés.

La solution cible

Dans la solution cible, rien ne doit être installé sur le poste client. L’utilisateur accède à un serveur distant à partir de son poste de travail. Il s’identifie sur ce serveur et accède à l’application merchandising qui permet d’élaborer les dossiers planogrammes.

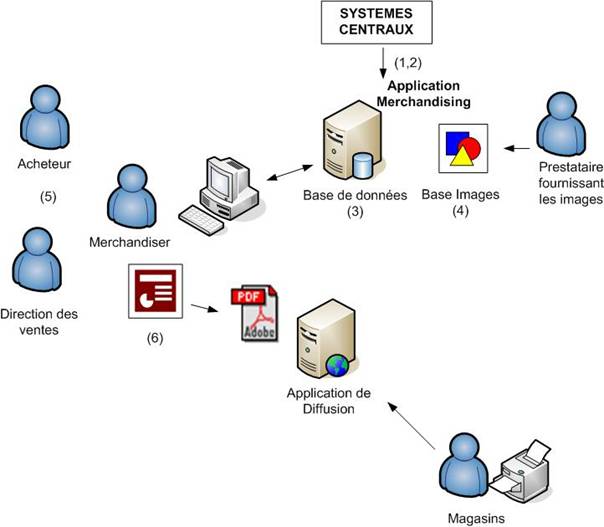

Le processus d’élaboration cible est le suivant (Figure 8) :

(1,2) Les informations correspondant aux produits et aux ventes sont directement disponibles dans l’outil d’élaboration. Le classement des magasins est géré de façon transparente, le merchandiser n’a plus à s’en soucier. Il n’a plus à faire de manipulation fastidieuse pour obtenir de l’information utilisable.

(3) Les informations anciennement gérées dans des fichiers autonomes seront gérées dans une base de donnée au travers d’une interface WEB.

(4) Les visuels correspondant aux produits sont livrés par un prestataire extérieur auprès duquel on souscrit un abonnement. Chaque mois, on lui envoie la liste des produits. En retour, les images manquantes sont envoyées puis intégrées dans la base image.

(5) Le merchandiser peut alors se consacrer à l’élaboration des planogrammes et des dossiers de préconisations en collaboration avec les bureaux d’achat et la direction des ventes.

(6) Une fois qu’un merchandiser a achevé un dossier de préconisations, un administrateur fonctionnel met à disposition le dossier dans l’application de diffusion au travers d’une interface d’administration WEB. Le magasin peut alors récupérer le dossier à l’aide d’un navigateur WEB et l’imprimer au besoin. Les dossiers ne sont plus envoyés au service de reprographie, ni livrés sous format papier à l’ensemble des magasins.

Figure 8 : L’outil d’élaboration cible

Les gains

L’automatisation d’un certain nombre de traitements permet d’éliminer de nombreuses interventions humaines et ainsi de réduire la durée du processus.

La gestion centralisée évite d’avoir un éclatement de l’information sur l’ensemble des postes utilisateurs. Cette gestion centralisée facilite les tâches d’administration.

La souscription d’un abonnement image et la mise à jour automatique de la base image libèrent les merchandisers de la gestion des images.

La mise en place d’une diffusion numérique des dossiers de préconisations permet aux magasins de les avoir plus rapidement. Il n’y a plus de livraison au magasin. Le magasin n’a plus qu’à choisir ce dont il a besoin via l’Intranet. Il peut alors imprimer les dossiers directement en magasin. De plus, il existe des gains financiers puisque cette diffusion entraîne une consommation de papier moins importante et permet de faire des économies en ne sollicitant plus le service de reprographie et le service courrier.

Ce nouveau processus « métier » va donc permettre de gagner du temps et de supprimer des tâches inutiles. On améliore ainsi la productivité du service merchandising. Le nombre de dossiers de préconisations de mise en rayon pourra être plus important en conservant le même effectif dans la cellule merchandising.

1.3. Les contraintes

Les contraintes pour mener à bien ce projet sont nombreuses et de natures diverses. Ces contraintes sont essentiellement techniques, politiques et financières.

Le Système d’Information est hétérogène. Toutes les informations nécessaires ne sont pas gérées dans ce dernier. De nombreuses informations relatives au merchandising sont dispersées dans des fichiers EXCEL sur chacun des postes des merchandisers. Il n’existe pas de référentiel centralisé contenant ces informations.

Les dossiers planogrammes nécessitent l’existence d’un référentiel image. Or, ce référentiel devrait se composer d’environ 46 000 images occupant plus de 10 Go d’espace disque. Ce qui exclut le fait de dupliquer ce référentiel sur chacun des postes, la taille de ce référentiel étant trop volumineuse.

La qualité visuelle de ces images est très importante, il est nécessaire que l’applicatif puisse au moins afficher 65 000 couleurs pour obtenir un rendu visuel acceptable.

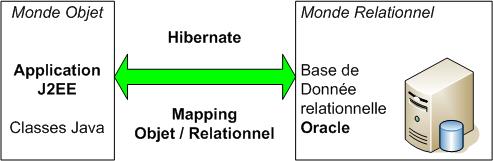

Outre ces contraintes techniques, la DSI (Direction des Systèmes d’Information) préconise fortement l’utilisation d’un certain nombre de solutions et de standards. Le choix d’ORACLE est préconisé pour les bases de données relationnelles, ainsi que de J2EE pour les développements Web. Ces préconisations ont pour but de limiter l’hétérogénéité du système.

La DSI a également adopté une politique de déploiement minimaliste des différentes applications à mettre en place sur les postes utilisateurs. C’est pourquoi les solutions Web sont préférées aux applications Clients – Serveur.

Enfin, malgré l’importance du projet, les moyens mis à notre disposition pour mener à bien ce projet sont très limités. Et la pression sur les délais à respecter est très grande.

1.4. Les étapes importantes du projet

Choix de la suite logicielle

La première étape de ce projet a consisté à choisir la suite logicielle qui répondait au mieux aux besoins identifiés des utilisateurs ou qui pouvait facilement être adaptée aux spécificités propres de leur métier.

Nous tenions à ce que le logiciel présente une interface intuitive, simple, conviviale, ceci pour diminuer la durée d’appropriation de l’application, dans le but de raccourcir la courbe de montée en compétence des merchandisers. Ils seront plus vite opérationnels si on met à leur disposition un outil simple, plutôt qu’un outil complexe et peu ergonomique.

Nous avons donc comparé les offres des principaux acteurs du marché : Prospace de JDA, SMART Office de KLEE Commerce, Apollo d’IRI et Spaceman de Nielsen. Les offres ne reposant pas sur des bases de données relationnelles et ne permettant pas de gérer un référentiel centralisé ont immédiatement été écartées.

Les deux offres qui sont alors restées en liste étaient Prospace de JDA et SMART Office de KLEE commerce. Elles ont été analysées de manière plus approfondie. Nous avons identifié l’ensemble des points fonctionnels et techniques auxquels devait répondre la suite logicielle. Des pondérations ont été attribuées à chacun de ces points en fonction de leur niveau d’importance. L’attribution de notes nous a alors permis d’effectuer un scoring des deux solutions et de choisir, en fonction des résultats, la suite qui correspondait le mieux à nos attentes. Le scoring utilisé est fourni dans l’Annexe L.

Notre choix s’est porté sur l’offre SMART Office de KLEE Commerce. C’est cette suite qui semblait répondre le mieux aux contraintes que nous avions et qui permettait d’améliorer au mieux le processus d’élaboration des planogrammes, selon les axes d’optimisation identifiés préalablement.

Cependant, cette suite ne permettait pas d’éviter les interventions sur les postes clients. En effet, on doit installer un applicatif client sur chacun des postes des utilisateurs. Ce problème a été contourné par l’utilisation de la technologie TSE de Microsoft. Cette technologie permet d’accéder à partir de n’importe quel poste Windows 2000, 2003 ou XP à des bureaux distants gérés par un serveur distant. Nous avons donc pu être en conformité avec les attentes de la DSI qui ne souhaitait pas d’intervention sur les postes clients.

D’autres critères plus subjectifs ont également joué un rôle dans le choix du produit, tels que la disponibilité et la réactivité de l’éditeur, et aussi le fait que l’éditeur puisse fournir des prestations complémentaires comme un abonnement image. L’éditeur livre chaque mois les visuels des produits sous forme numérique correspondant à un certain périmètre.

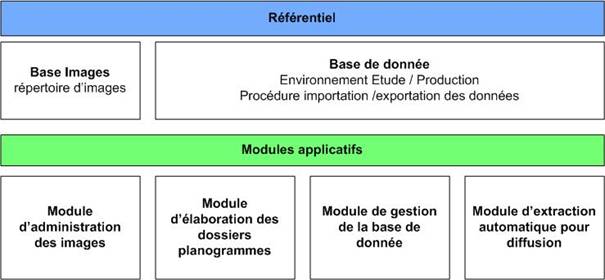

L’offre de KLEE repose sur un référentiel composé d’une base image, d’une base relationnelle de type ORACLE et d’un ensemble de modules. Les modules vont permettre d’administrer la base image, d’élaborer les dossiers planogrammes, de gérer la base de données et d’extraire de l’information de façon automatique.

Figure 9 : Architecture de la suite logicielle SMART Office

Intégration de cette suite dans le système

La seconde étape consiste à intégrer cette suite logicielle dans le Système d’Information existant. Il est possible d’alimenter les bases de données à l’aide de fichiers « texte » en paramétrant des fichiers XML, ce qui permet d’être assez souple au niveau de l’alimentation des données. Il ne reste donc plus qu’à collecter l’information nécessaire à l’élaboration des planogrammes.

Nous avons donc identifié les traitements à mettre en place pour alimenter le référentiel et précisé la fréquence à laquelle ils devaient être exécutés.

Les grands groupes de traitements sont les suivants :

· alimentation des informations relatives aux produits

· récupération des classements des magasins en terme de ventes par ensemble de produits

· récupération des ventes par produit correspondant à chacun des magasins

· envoi de la liste des produits présents dans le référentiel à l’éditeur afin de recevoir les visuels des produits correspondant à l’abonnement image souscrit.

Hormis l’alimentation des informations relatives aux produits qui est exécutée chaque jour de la semaine, les autres traitements sont mensuels.

Etant donné que l’information présente dans le Système d’Information n’est pas directement exploitable, nous avons, avant de créer les fichiers qui serviront à alimenter le référentiel de l’offre de KLEE Commerce, mis en place un Datamart.

Figure 10 : Mise en place d’un Datamart

C’est une base de données qui contient toutes les informations relatives au merchandising et à l’historique des ventes sur une période d’un an permettant l’élaboration des planogrammes. Ce Datamart était initialement prévu pour fournir le bon niveau d’agrégation de l’information nécessaire à la suite SMART Office. Mais, la prise en compte d’évolutions fonctionnelles telles que la gestion de regroupements particuliers de produits en univers ont eu pour conséquence d’élargir son utilisation à la gestion de notions propres au merchandising qui n’étaient pas gérées dans le Système d’Information existant.

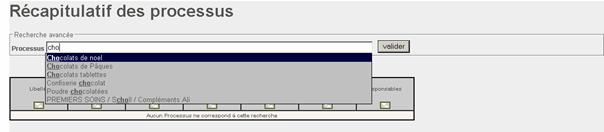

La gestion des univers, qui sont des regroupements de produits propres au merchandising, permet de gérer des périmètres de produits correspondant exactement aux dossiers planogrammes envoyés aux magasins. Ce qui n’était pas le cas jusqu’alors, les périmètres des dossiers correspondaient à des regroupements de sous-ensembles de nomenclature produit utilisés dans l’entreprise. Ces regroupements étaient difficilement gérables par les merchandisers.

On veut également gérer, dans cette base, la liste des dossiers planogrammes et leurs caractéristiques telles que leurs fréquences de mise à jour ou la personne en charge du planogramme. Jusqu’à présent, cette gestion était faite à l’aide de fichiers EXCEL.

Le fait de vouloir diffuser les planogrammes sous forme de fichiers PDF via l’intranet oblige également à gérer un ensemble de notions : une arborescence de diffusion, une identification des magasins pour pouvoir ensuite filtrer la liste des dossiers proposés en fonction de leurs caractéristiques.

La gestion de ces notions ne pouvait pas se faire dans l’offre SMART Office de KLEE Commerce car elles revêtent un caractère « métier » qui n’a pas lieu d’être géré dans un tel outil. Il est important que cet outil reste indépendant des données propres de l’entreprise.

Mise en œuvre d’interfaces Web

Le fait de gérer ces notions au niveau du Datamart oblige à se doter d’interfaces qui vont permettre de les administrer et de suivre la bonne exécution des différents traitements.

Pour cela, il est nécessaire de choisir des normes et des outils de développement, de mettre en place une architecture et de valider cette architecture à l’aide d’un outil de stress test que nous aurons préalablement sélectionné. Cette validation servira à s’assurer que l’application offre la qualité de service attendu pour éviter de se retrouver avec un système indisponible le jour de sa mise en production parce qu’il n’aura pas tenu la charge générée par les utilisateurs.

2. Présentation des méthodologies, technologies et concepts utilisés

2.1. Gestion et management de projet

La gestion de projet informatique est fondée sur des travaux de modélisation et de collaboration. Un client demande à un fournisseur, qu’il soit interne ou externe à l’entreprise, de mettre en place une solution à sa problématique au travers d’un modèle. Les deux parties prenantes doivent alors collaborer en bonne intelligence afin d’atteindre un objectif commun.

L’Informatique est une discipline jeune en comparaison des domaines millénaires du bâtiment et des systèmes de collaborations militaires. La réalisation d’un projet informatique traditionnel suppose en général la maîtrise des techniques de planification, des connaissances en ISO 9001 et d’UML. Il existe de nombreuses normes et méthodes utilisables dans la réalisation d’un projet informatique. On constate cependant que ces normes et ces méthodes convergent aujourd’hui vers certaines méthodes et techniques telles que les Design patterns, UML ou Java. Par le respect de règles et méthodes, on cherche à produire des solutions de qualité documentées afin de répondre aux problématiques rencontrées par les entreprises. La documentation est perçue comme un facteur permettant de contribuer à l’obtention d’une solution de qualité mais elle représente parfois un coût important.

La qualité de la collaboration et le maintien du dialogue entre le client et les fournisseurs d’un projet sont des conditions indispensables au bon déroulement du projet. La bonne réussite d’un projet informatique repose sur cette collaboration. Si le client est satisfait, il sera confiant et, en général, permettra au fournisseur d’être plus libre dans sa gestion de projet. Pour remplir pleinement son rôle le fournisseur doit se mettre à la place de son client. Il pourra ainsi effectuer une analyse pertinente de la problématique à laquelle il est confronté et répondre pleinement aux contraintes fonctionnelles et techniques. Le fournisseur doit avant tout préciser avec le client le contexte du projet et en définir le contenu. Il est nécessaire de bien définir l’alignement stratégique du projet et de dégager les différents processus « métier » cibles, ainsi que les règles « métier » associées.

Suite à cette phase de pré étude, les dirigeants d’une entreprise décident ou non de lancer le projet.

Dans le cas d’une décision favorable, il faut conduire le projet. Il est alors nécessaire de mettre en place une organisation et une méthodologie de gestion de projet. Les grandes lignes de cette méthodologie consistent à analyser les besoins, évaluer les charges, définir et suivre les différents incréments à mettre en place, identifier et gérer les risques, définir l’architecture technique et applicative, gérer au mieux la réutilisation, et maîtriser les ressources humaines ainsi que les ressources logicielles.

Il existe plusieurs types de projet : les projets de développement, les projets d’intégration et les projets de déploiement. Certains projets peuvent appartenir à plusieurs de ces types.

C’est entre autres le cas du projet merchandising. Dans ce projet, il a été nécessaire de mettre en place une solution spécifique au travers de développement, d’intégrer un progiciel dans le Système d’Information de l’entreprise et de déployer ces solutions au sein de l’entreprise.

Il est crucial que le projet ait un objectif clairement défini, limité et unique. En général, un projet est caractérisé par un niveau de complexité important. On peut caractériser cette complexité en identifiant les charges globales, les savoir-faire requis et les risques encourus.

Les limites du projet doivent être définies de manière précise en terme de délais, de moyens financiers, de ressources et de personnels.

La gestion d’un projet Informatique commence par la précision du contexte, des acteurs, de leurs interactions et l’identification des processus « métier ». On s’intéresse tout d’abord à définir la démarche projet. Le projet suit un cycle de vie. Des modèles et méthodes sont utilisés pour décrire son contenu.

Le cycle de vie comporte plusieurs étapes :

· Pré étude

· Evaluation des besoins et des charges

Décomposition en tâches et détermination de lots.

· Budgétisation

Associer des coûts aux tâches. Déterminer des rubriques budgétaires globales et des réserves.

· Rédaction de l’offre et du contrat

· Kick Off

Démarrage officiel du projet pour canaliser l’énergie des différents acteurs.

· Planification

Détermination d’un échéancier et du calendrier.

· Conception

· Implémentation et tests

· Recette

· Mise en production

· Achèvement

· Maintenance

On peut différencier les cycles de vie correspondant à des développements spécifiques ou à des développements de progiciel.

Ces deux types de développements se différencient essentiellement sur la phase de développement. Les phases de définition, d’exploitation, d’utilisation, de maintenance et d’évolution sont gérées de manière identique. Dans le premier cas, il s’agit de mener une étude préalable, suivie d’une étude détaillée, d’une étude technique de mise en œuvre et de la mise en œuvre à proprement parler. Dans le second cas, il s’agit de choisir un progiciel, d’effectuer le paramétrage afin de répondre au besoin, de tester les adaptations effectuées.

D’autre part, dans le cas du développement d’un logiciel spécifique au sein d’une entreprise, la phase de « rédaction de l’offre et du contrat » est moins formelle.

2.2. Les modèles et les méthodes

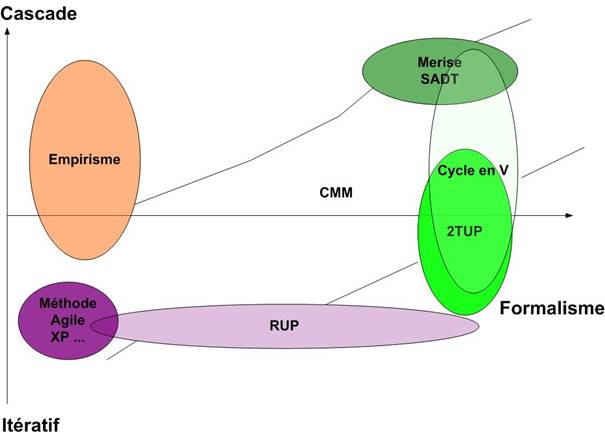

Il existe plusieurs modèles de déroulements type de projet. Le déroulement d’un projet dépend de sa nature et de son contexte. Il n’y a pas de méthode universelle qui puisse être appliquée à tous les projets. On peut différencier deux types de méthodes de gestion de projets. Les méthodes traditionnelles suivent des cycles séquentiels et sont basées sur des contrats. Les méthodes plus modernes positionnent l’utilisateur comme un acteur clef du projet et préfèrent satisfaire ce dernier plutôt qu’honorer les clauses d’un contrat.

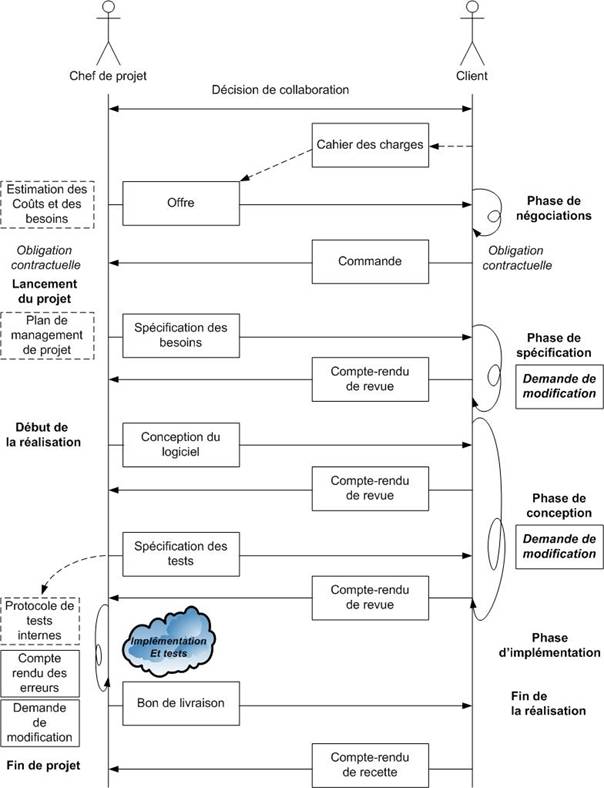

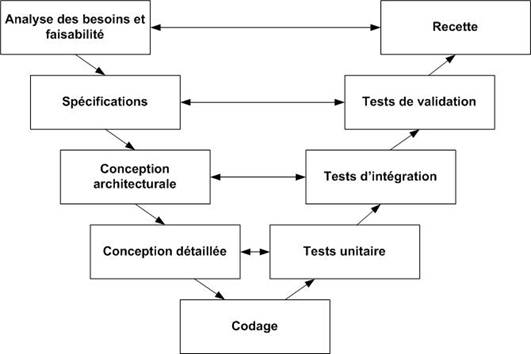

Ci-dessous, un diagramme illustrant le déroulement type d’un projet traditionnel [MAN06].

Figure 11 : Déroulement type d’un projet traditionnel

Cycles de projet

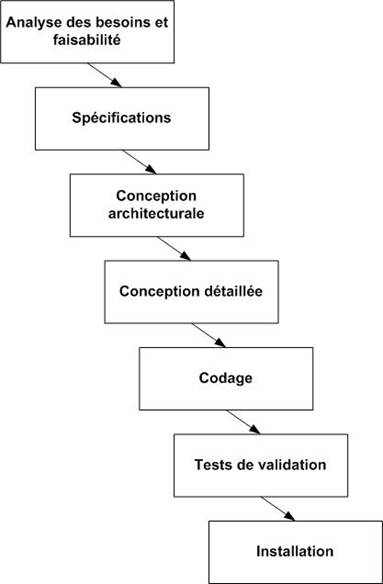

Lors de la réalisation d’un logiciel, plusieurs types de cycles de développement sont possibles. Les grandes familles sont les cycles en cascade, les cycles en V et les cycles itératifs.

Cascade

Figure 12 : Cycle de vie en cascade

Ce cycle de vie en cascade (Figure 12) est hérité du bâtiment. Les phases traditionnelles de développement sont effectuées les unes après les autres, avec un retour sur les précédentes, voire au tout début du cycle. Chacune des phases produit des livrables définis au préalable et se termine à une date précise. Une étape de validation et de vérification des livrables permet de terminer une phase.

V

Depuis les années 1980, le cycle en V (Figure 13) est devenu un standard de l'industrie du développement de logiciel et de la gestion de projet.

Ce cycle limite les retours aux étapes précédentes afin de pallier le problème de réactivité du modèle en cascade. Les phases de la partie montante, renvoient de l'information sur les phases en vis-à-vis. Les livrables des étapes montantes sont préparés dans les étapes descendantes. Par exemple, les livrables des tests de validation sont définis lors des spécifications.

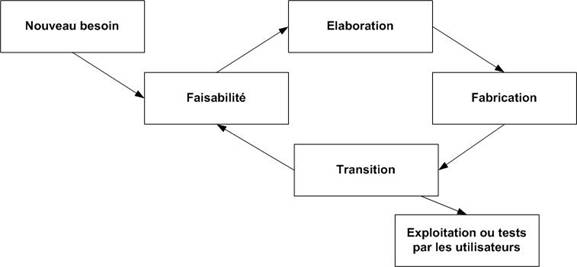

Itératif

Figure 14 : Cycle de vie itératif

Le produit issu d'une activité est appelé un artéfact. On distingue les activités des artéfacts. Un cycle de type roue de Deming est appliqué sur la production des livrables : documentation, code, test.

Dans le cas d’une gestion de projet, on étudie la faisabilité d’un nouveau besoin. On élabore une solution. Une phase de fabrication permet ensuite de construire cette solution. La livraison au client correspond à la transition.

Dans un cycle itératif (Figure 14 ci dessus), les phases de faisabilité, d’élaboration, de fabrication et de transition correspondent respectivement aux phases de spécifications, de détermination de l’architecture, de développement et de tests. L'objectif est d’effectuer au plus tôt les livraisons au client afin qu’il puisse effectuer une recette.

Une itération est plus courte et régulière qu'une roue de Deming (PDCA) qui, appliquée à une organisation importante, peut prendre plusieurs années.

Comparaison

Le cycle en V a pour origine l'industrie lourde. Les phases de validation sont importantes car les phases successives du projet sont de plus en plus lourdes. Dans le cas de gros projets réunissant un nombre important de personnes, les décisions de la direction ou des architectes ont tellement d’impact en terme de charge et de durée qu'il est important de s'assurer de la validité de chacune des étapes.

Dans le cas d'un projet logiciel impliquant peu de personnes sur des durées courtes de l’ordre d’une à deux années, on dispose d'une plus grande réactivité du fait de la proximité géographique et d’une communication facilitée compte tenu de la taille de l’équipe. De plus, les coûts sont plus limités entre chaque étape. Dans ce contexte, il est possible d’utiliser des méthodes de développement dites agiles en diminuant le formalisme et en multipliant le nombre de cycles.

Tests et validation des logiciels

Les tests sont une activité centrale. Ils permettent d’améliorer la qualité des logiciels. Le maître d’œuvre d’un projet peut mettre une stratégie de test en place qui se compose de tests unitaires, tests d’intégration, de vérification et de validation.

La validation met en évidence les défauts d’un logiciel et sa conformité par rapport à ses spécifications. Cette étape permet de gérer les anomalies, d’évaluer la conformité fonctionnelle et la fiabilité du logiciel.

Il existe deux grandes familles de tests. Les tests fonctionnels qui permettent d’évaluer l’ergonomique, la robustesse, la réponse au stress ou le niveau de performance d’un logiciel et les tests structurels qui permettent des analyses de la couverture du code, des analyses statistiques ou des analyses de complexités. Ces différents tests peuvent être automatisés. Des outils permettent l’automatisation de tests, la capture et le rejeu (Opensta, Selenium), ou encore l’analyse de couverture (RCOV pour ruby).

D’autre part, des techniques de vérification telles que les revues peuvent être effectuées par le client. A l’aide de ces revues, les dérapages sont limités, voire évités. Les coûts sont réduits par la correction des problèmes des résultats intermédiaires. Le résultat obtenu correspond d’avantage au résultat attendu. De plus, ces revues permettent de partager les responsabilités du projet entre le client et le fournisseur.

La réalisation de test permet de détecter les erreurs. Mais cette détection doit être réalisée au plus tôt. Plus une erreur est détectée tôt moins elle est coûteuse à corriger. Le coût de la correction d’une erreur au niveau de l’analyse est beaucoup moins important que le coût de la correction d’une erreur au niveau de la conception. Si la correction de cette erreur s’effectue dans les phases d’implémentation ou d’exploitation, les coûts de correction peuvent être 1000 fois plus importants.

Méthode Agile : panorama des principales méthodes

Une méthode agile est une méthode de développement informatique [BEN05]. Le client est impliqué un maximum dans le projet. La réactivité aux demandes est donc très bonne. Les méthodes agiles se veulent plus pragmatiques que les méthodes traditionnelles. On cherche à satisfaire un client plutôt que les clauses d’un contrat.

La méthode recherche la production d’un code de qualité. Les développements sont guidés par les tests.

L’objectif de ces méthodes est de permettre de mieux maîtriser les délais, les coûts et la production des projets informatiques.

Les développements sont effectués de façon itérative et incrémentale.

La méthode RAD est à l’origine des méthodes agiles. Les méthodes agiles sont le résultat de la recherche d’approches plus adaptées aux nouvelles technologies dans lesquels des cycles courts sont favorisés.

Les méthodes agiles prônent 4 valeurs fondamentales qui sont présentées dans le manifeste agile:

· L'équipe : « Personnes et interaction plutôt que processus et outils »

· L'application : « Logiciel fonctionnel plutôt que documentation complète »

· La collaboration : « Collaboration avec le client plutôt que négociation de contrat »

· L'acceptation du changement : « Réagir au changement plutôt que suivre un plan »

Les 4 valeurs se déclinent en 12 principes :

· « Notre première priorité est de satisfaire le client en livrant tôt et régulièrement des logiciels utiles ».

· « Le changement est bienvenu, même tardivement dans le développement. Les processus agiles exploitent le changement comme avantage compétitif pour le client ».

· « Livrer fréquemment une application fonctionnelle, toutes les deux semaines à deux mois, avec une tendance pour la période la plus courte ».

· « Les gens de l'art et les développeurs doivent collaborer quotidiennement au projet ».

· « Bâtissez le projet autour de personnes motivées. Donnez leur l'environnement et le soutien dont elles ont besoin, et croyez en leur capacité à faire le travail ».

· « La méthode la plus efficace de transmettre l'information est une conversation en face à face ».

· « Un logiciel fonctionnel est la meilleure unité de mesure de la progression du projet ».

· « Les processus agiles promeuvent un rythme de développement soutenable. Commanditaires, développeurs et utilisateurs devraient pouvoir maintenir le rythme indéfiniment ».

· « Une attention continue à l'excellence technique et à la qualité de la conception améliore l'agilité ».

· « La simplicité - l'art de maximiser la quantité de travail à ne pas faire - est essentielle ».

· « Les meilleures architectures, spécifications et conceptions sont issues d'équipes qui s'auto organisent ».

· « À intervalle régulier, l'équipe réfléchit aux moyens de devenir plus efficace, puis accordé et ajuste son comportement dans ce sens ».

Un panorama des principales méthodes : RAD, Crystal Clear, Scrum, DSDM, XP, UP, RUP est présenté ci-dessous.

RAD

RAD est l’acronyme de Rapid Application Development. C’est une méthode de développement de logiciels dont le cycle de développement est très court. Elle a été développée par James Martin dans les années 1980.

La réalisation et les tests de l’application sont effectués par morceau à intervalles réguliers. Dans cette méthode, des environnements graphiques sont utilisés afin d'obtenir rapidement des prototypes.

Crystal clear

Crystal clear est une méthode de gestion de projet crée par Alistair Cockburn. Cette méthode est adaptable aux spécificités des projets. Elle repose sur un certain nombre de principes auquel doit adhérer l'ensemble de l'équipe :

- La communication a une place importante dans le projet afin de faire collaborer les différents acteurs du projet de manière efficace.

- Le nombre des membres d'une équipe est limité à six personnes pour améliorer la solidarité.

- l'équipe travaille dans une même pièce pour que la proximité facilite la communication.

- Les schémas de modélisation sont effectués en groupe sur tableau blanc pour une meilleure communication et une meilleure collaboration.

- La collaboration avec le client est très importante. Les discussions entre les utilisateurs et les développeurs sont nombreuses.

- Des parties exécutables de l'application sont livrées fréquemment. Le client peut ainsi se rendre compte de l’avancement du projet et faire des retours sur les livraisons.

La méthode Crystal clear reste très souple au niveau des procédures à suivre et des normes à utiliser. La procédure est découpée en différentes étapes :

- Les utilisateurs sont observés dans leur travail afin de mieux comprendre leurs besoins et leur contexte. Les fonctionnalités sont classées par ordre de priorité en collaboration avec les utilisateurs. Les fonctionnalités avec la plus haute priorité sont développées en premier.

- Au début du projet, une ébauche de conception et une ébauche d’architecture sont réalisées.

- On planifie les dates des itérations. Des livrables fonctionnelles sont définies à la fin de chacune d’elles.

- La réalisation proprement dite de l'application se fait durant les itérations.

La méthode Crystal clear présente tous les avantages des méthodes agiles : flexibilité par rapport au changement, rapidité, livraisons fréquentes. Elle convient aux petites structures. Elle est très efficace dans les projets de petite taille mais n’est pas adéquate pour des projets importants.

Scrum

Scrum est une méthode agile pour la gestion de projets. Elle a été conçue pour améliorer la productivité en évitant de paralyser les équipes par l’emploi de méthodologies trop lourdes.

Ken Schwaber et Jeff Sutherland ont mis au point les grands principes de Scrum au début des années 1990.

Le terme Scrum est emprunté au rugby et signifie mêlée. L’utilisation de ce terme est une analogie au rugby du fait que le processus s'articule autour d'une équipe soudée, qui cherche à atteindre un but.

Dans cette méthode, on focalise l'équipe de façon itérative sur un ensemble de fonctionnalités. L’équipe doit réaliser ces fonctionnalités durant des itérations de l’ordre de 30 jours appelées Sprints.

Un but à atteindre est défini dans chaque Sprint. On détermine un ensemble de fonctionnalités à implémenter. Le sprint aboutit à la livraison d'un produit proposant les nouvelles fonctionnalités.

Un ScrumMaster a pour rôle de réduire les perturbations extérieures et de résoudre les problématiques non techniques de l'équipe.

Le client participe de façon active. Il priorise la réalisation des fonctionnalités du logiciel. Il a la possibilité de changer la liste des fonctionnalités désirées à condition qu’elles ne soient pas en cours de réalisation.

Dynamic Systems Development Method

Dynamic Systems Development Method (DSDM) est une méthode de gestion de projet de la catégorie des méthodes agiles. Cette méthode a été développée en Grande-Bretagne à partir de 1994

La méthode DSDM s'appuie sur 9 principes de base :

· Implication des utilisateurs durant tout le cycle de développement. Ils font partie de l'équipe projet.

· Autonomie. L'évolution des besoins peut être influencée par l’équipe projet.

· Visibilité du résultat. Un feed-back rapide est possible par des livraisons fréquentes.

· Adéquation. On cherche à livrer une application en adéquation avec le besoin « métier » du client.

· Développement itératif et incrémental. L'évolution du développement est basée sur le feed-back des utilisateurs.

· Réversibilité. Toute modification effectuée durant le développement doit être réversible.

· Synthèse. Un schéma directeur définit le périmètre et les grandes lignes du projet.

· Tests. Les tests sont effectués en continu, en parallèle du développement.

· Coopération. Il est nécessaire d’être souple par rapport aux modifications des fonctionnalités demandées.

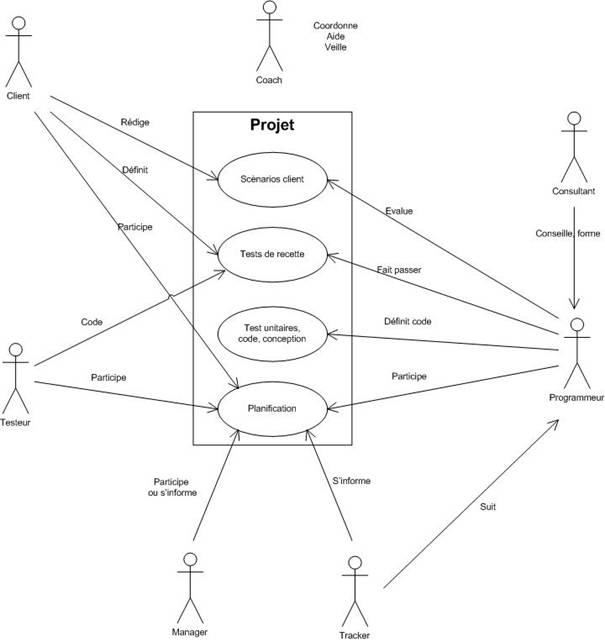

Extreme programming

L'Extreme Programming (XP) est une méthode agile de gestion de projet informatique [BEN05]. Elle est adaptée aux équipes de petite taille qui sont confrontées à des besoins changeants. Des principes simples sont poussés à l'extrême.

L'Extreme Programming a été inventée par Kent Beck, Ward Cunningham et Ron Jeffries pendant un projet "C3" de calcul des rémunérations chez Chrysler entre 1996 et 1999.

Le but principal est de réduire les coûts liés au changement. Dans les méthodes traditionnelles, les besoins sont définis et fixés, au départ du projet. Les coûts ultérieurs de modifications s’en trouvent accrus. Cette méthode fait en sorte de rendre le projet plus flexible et ouvert au changement. Elle introduit des valeurs de base et des principes. Elle repose sur un certain nombre de pratiques.

Elle utilise des principes qui ne sont pas nouveaux mais elle les pousse à l'extrême :

· la revue de code est permanente et effectuée par binôme

· les tests sont systématiques et effectués avant chaque implémentation

· la conception se fait tout au long du projet (refactoring)

· on choisit toujours la solution la plus simple

· l’emploi de métaphores permet d’améliorer la compréhension

· l'intégration des modifications s’effectue plusieurs fois par jour

· pour s’adapter au changement, les cycles de développement sont très rapides.

Les cycles de développement rapides impliquent des itérations très courtes qui peuvent durer moins d’une semaine. Une itération se compose d’un ensemble d’étapes qui permettent de :

· déterminer les scénarios clients de l’itération

· transformer les scénarios en tâches à réaliser et de déterminer les tests fonctionnels correspondants

· réaliser les tâches en binôme

· valider et livrer les fonctionnalités développées au client

Tant que le client fournit des scénarios, le cycle se répète. La première livraison est en générale la plus longue à réaliser mais peut aboutir après quelques itérations. Après avoir mis en production, les itérations peuvent être encore plus fréquentes.

UP

Processus Unifié (PU) ou en anglais Unified Process (UP) est une méthode de prise en charge du cycle de vie des logiciels orientés objets. Elle est générique, itérative et incrémentale, contrairement à Merise ou SADT qui sont des méthodes séquentielles.

RUP, proposé par la société Rational, est l’une des plus célèbres implémentations de la méthode PU. C’est une solution livrée clés en main qui permet d’avoir un cadre de développement logiciel. Cette méthode est guidée par les besoins des utilisateurs et centrée sur l’architecture logicielle.

Les processus unifiés utilisent UML. UML est un langage de modélisation. Mais UML ne prend pas en charge le cycle de vie du logiciel, le processus de création et de conception des modèles. La prise en compte de la diversité des projets, des problématiques, des équipes et des cultures d’entreprise dans une seule et unique méthode n’étant pas aisée, PU tente de couvrir cette lacune. PU est générique et possède de nombreux avatars afin de répondre à la diversité des situations :

· RUP : Rational Unified Process, processus défini par la société Rational Software (IBM)

· EUP : Enterprise Unified Process, processus intégrant les phases de post-implantation et décrivant le cycle de vie du logiciel

· XUP : Extreme Unified Process, processus intégrant UP avec l’extreme programming.

· AUP : Agile Unified Process, processus mettant l’accent sur l’agilité des développements. Il s’appuye plus sur l’optimisation et l’efficience sur le terrain que sur la modélisation

· 2TUP : Two Tracks Unified Process, processus proposé par Valtech prenant en compte les aléas et contraintes liés aux changements perpétuels et rapides des SI des entreprises.

· EssUP : Essential Unified Process, par Ivar Jacobson, à l’initiative d'UML et RUP. Ce processus unifié intègre certains concepts des méthodes Agile.

RUP

RUP repose sur 6 principes :

· développement itératif

· traitement et formalisation des exigences

· architecture à base de composant

· modélisation visuelle

· vérification de la qualité du logiciel

· gestion du changement

RUP est caractérisé par un découpage temporel en phases et itérations, l’utilisation d’un support entièrement informatique et un aspect générique et paramétrable.

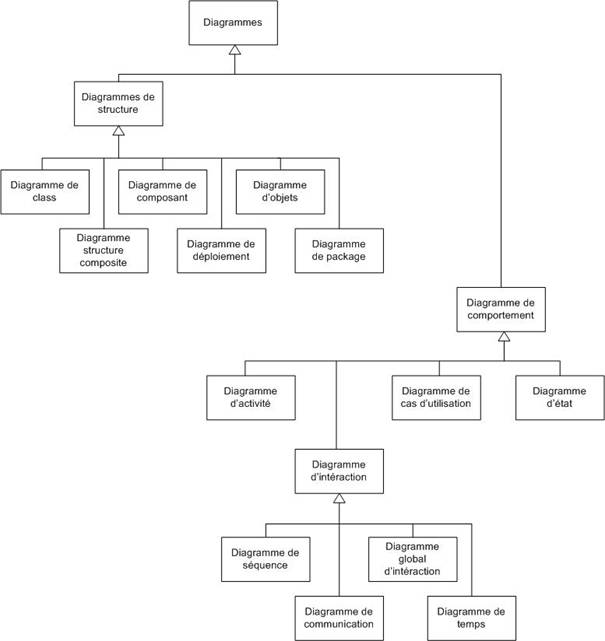

UML

UML signifie Langage de Modélisation Unifié (Unified Modeling Language) [ROQ00] [ROQ07]. C’est un langage graphique de modélisation. Il représente une formalisation très aboutie et non propriétaire de la modélisation objet utilisée en génie logiciel. UML n'est pas une méthode.

UML est issu des travaux de Grady Booch, James Rumbaugh et Ivar Jacobson. Il est né de la fusion des langages de modélisation objet Booch, OMT, OOSE. UML est un standard défini par l'OMG (Object Management Group).

Le modèle UML 2 est composé de 13 types de diagrammes alors que UML 1.3 n’en comportait que 9.

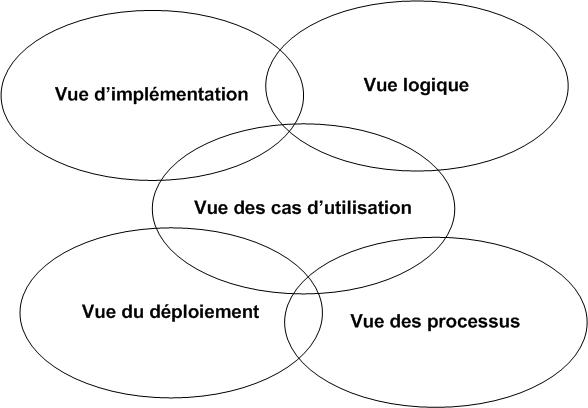

UML se décompose en plusieurs sous-ensembles : les vues, les diagrammes et les modèles d’éléments.

Les vues décrivent le système d'un point de vue donné (organisationnel, dynamique, temporel, architectural, géographique, logique …). Les vues sont des notions abstraites. La combinaison de ces vues définit le système complet.

Les diagrammes décrivent le contenu des vues à l’aide d’éléments graphiques. Les diagrammes peuvent faire partie de plusieurs vues.

Les modèles d'éléments tels que les cas d'utilisation, les classes ou les associations permettent d’élaborer les diagrammes UML.

Une façon de mettre en oeuvre UML est de considérer différentes vues superposables pour collaborer à la définition du système : vue d’implémentation, vue logique, vue des cas d’utilisation, vue de déploiement et vue des processus (Voir Figure 15).

Figure 15 : Les différentes vues dans UML

· Vue des cas d'utilisation :

Elle représente le point de vue des acteurs du système et correspond aux besoins.

· Vue logique :

On définit le système de l’intérieur. Elle explique la manière de satisfaire les besoins utilisateurs.

· Vue d'implémentation :

Elle permet de définir les dépendances entre les modules.

· Vue des processus :

Elle met en œuvre les notions de tâches concurrentes, stimuli, contrôles et synchronisations. Elle couvre des aspects temporels et techniques.

· Vue de déploiement :

Elle décrit la position géographique et l'architecture physique de chacun des éléments du système.

Ces différents points de vues permettent de répondre aux questions suivantes : Quoi ? Qui ? Comment ? Où ? Seul le pourquoi n’est pas défini à l’aide d’UML.

Les 13 diagrammes UML sont dépendants hiérarchiquement et se complètent (voir Figure 16 et Tableau 1). Ci-dessous est présentée la hiérarchie des diagrammes UML 2.0 sous forme d'un diagramme de classes.

Figure 16 : La hiérarchie des diagrammes UML 2.0

Tableau 1 : Diagrammes UML 2.0

|

Nom du diagramme |

Description |

|

Diagrammes Structurels ou Diagrammes statiques (Structure Diagram) |

|

|

Class diagram |

Il représente les classes intervenant dans le système. |

|

Object diagram |

Il sert à représenter les objets utilisés dans le système. |

|

Component diagram |

Il décrit le point de vue physique des composants du système. Il présente, en particulier, leur mise en œuvre (fichiers, bibliothèques, bases de données...) |

|

Deployment diagram |

Il représente les éléments matériels (ordinateurs, périphériques, réseaux, systèmes de stockage...), la répartition des composants du système sur ces éléments matériels et la façon dont ils interagissent. |

|

Package Diagram |

Il permet de représenter les dépendances entre regroupement d’éléments, ainsi qu’entre packages. |

|

Diagramme de structure composite Composite Structure Diagram |

Les relations entre composants d'une classe sont décrites sous forme de boîtes blanches. |

|

Diagrammes Comportementaux ou Diagrammes dynamiques (Behavior Diagram) |

|

|

Diagramme des cas d'utilisation Use case diagram |

Il identifie les possibilités d'interaction entre le système et les acteurs. Les fonctionnalités que doit fournir le système sont alors précisées. |

|

State Machine Diagram |

Le comportement du système ou de ses composants est décrit sous forme de machine à états finis. |

|

Activity Diagram |

Le comportement du système ou de ses composants est décrit sous forme de flux ou d'enchaînements d'activités. |

|

Diagramme d'interactions (Interaction Diagram) |

|

|

Sequence Diagram |

Le déroulement des traitements et des interactions entre les éléments du système et/ou de ses acteurs est représenté de manière séquentielle. |

|

Communication Diagram |

C’est un diagramme de séquence simplifié qui se concentre sur les échanges de messages entre les objets. |

|

Diagramme global d'interaction Interaction Overview Diagram |

Ce diagramme décrit les enchaînements possibles entre les scénarios préalablement identifiés sous forme de diagrammes de séquences. Un diagramme de séquence est une variante du diagramme d’activité. |

|

Timing Diagram |

Il décrit les variations d'une donnée au cours du temps. |

Ci-dessous un tableau récapitulant les différents diagrammes utilisés en fonction des vues.

Tableau 2 : Diagrammes en fonction des vues

|

Vues |

diagrammes |

|

Vue logique |

Diagramme de classes et d’objets |

|

Vue d’implémentation |

Diagramme de composants |

|

Vue cas d’utilisation |

Diagramme de cas d’utilisation |

|

Vue processus |

Diagramme d’activité, séquence, collaboration |

|

Vue déploiement |

Diagramme de déploiement |

Le langage UML 2.0 a été lancé en 2003 [BOR04]. Il présente une avancée très intéressante du support de communication. On peut utiliser UML 2 comme on utilisait UML 1.3.

UML 2 est très influencé par les processus MDA (Model Driven Architecture) et MDD (Model Driven Development). L'un des objectifs d’UML 2 est de parvenir à une automatisation du développement afin de passer directement du modèle au code source et donc de fournir un programme compilé, prêt à être lancé. C’est pourquoi les sémantiques des modèles UML ont été précisées afin d'éviter des problèmes d'interprétation. Selon le niveau d'abstraction, sans pour autant devoir programmer, les modèles se rapprochent des programmes eux-mêmes. Un autre objectif serait de générer également de façon automatique les tests cases qui accompagnent le programme.

Le niveau d'abstraction du langage est donc plus élevé que dans la version précédente. UML 2 bénéficie d’un langage enrichi qui a été modularisé en différents sous langages qui peuvent être combinés.

La nouvelle version d’UML ajoute 4 autres diagrammes : le diagramme des paquetages (package diagram), le diagramme de structure composite (composite structure diagram), le diagramme global d'interaction (interaction overview) et le diagramme de temps (timing diagram).

D’autre part, le diagramme de collaboration d'UML 1.4 est devenu diagramme de communication dans UML 2.0 et la plupart des diagrammes ont été revus pour répondre aux nouveaux besoins d’abstraction et d’automatisation...

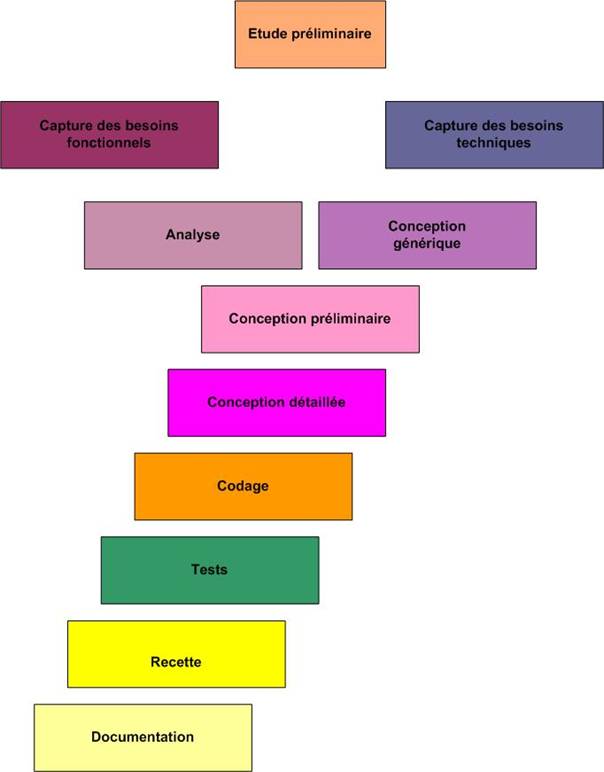

Processus 2TUP

2TUP signifie 2 Track Unified Process [ROQ00] [ROQ07]. C’est un processus de développement logiciel qui implémente le Processus Unifié.

Le 2TUP repose sur un cycle de développement en Y (Figure 17) permettant de dissocier les aspects techniques des aspects fonctionnels. Il commence par une étude préliminaire. Cette étude préliminaire permet d’identifier les acteurs qui vont interagir avec le système à construire, d’identifier les messages qu'échangent les acteurs et le système, de produire le cahier des charges et de modéliser le contexte. Ensuite, le processus s'articule autour de 3 phases essentielles : une phase technique (branche de droite), une phase fonctionnelle (branche de gauche) et une phase de réalisation.

Le processus 2TUP repose sur une démarche itérative et incrémentale pour diminuer les risques et organiser la production des livrables. Il sépare les préoccupations fonctionnelles et techniques.

Le processus 2TUP permet le développement de progiciels objet. C’est pour cette raison que l’analyse est très centrée sur la détermination de classes et que la modélisation objet est très présente dans chacune des étapes du processus (Tableau 3).

Tableau 3 : Description des différentes étapes du processus

|

Phase |

Description |

|

Etude préliminaire Capture initiale des besoins |

Effectuer un recueil initial des besoins fonctionnels et techniques Préciser le contexte, les acteurs, les interactions |

|

Capture des besoins fonctionnels |

Compléter le recueil des besoins Rechercher les classes candidates Produire un modèle des besoins Qualifier les risques de non réponse aux besoins |

|

Capture des besoins techniques |

Déterminer les contraintes et les choix dimensionnant le système Prendre en compte des contraintes d’intégration Prendre en compte des contraintes techniques et logicielles Déterminer la configuration matérielle Sélectionner les outils et les matériels Définir le style d’architecture en tiers Etablir la spécification logicielle (gestion des erreurs, sécurité, distribution, intégrité, utilisation de l’aide) Définir les couches logicielles (modèle en 5 couches et couche de synchronisation avec le SI) |

|

Analyse |

Etudier les spécifications fonctionnelles Veiller à ce que le résultat de l’analyse ne dépende d’aucune technologie Définir le modèle structurel d’analyse : Découper les classes en catégories (cohérence, indépendance) Définir le modèle statique d’analyse : Détailler, compléter, optimiser les diagrammes de classes Définir le modèle dynamique : Déterminer la collaboration entre objets (diagramme interaction et diagramme d’état) Itérer sur les deux derniers modèles |

|

Conception générique |

Définir des composants nécessaires à l’architecture technique Uniformiser et réutiliser les mêmes mécanismes pour tout le système Construire le squelette Ecarter les risques Déterminer les Frameworks et les Design patterns Organiser l’architecture technique et les composants Veiller à répondre à des objectifs de réutilisation, de fabrication et de déploiement Déterminer les couches, le modèle logique et le modèle d’exploitation Valider avec un prototype |

|

Conception préliminaire |

Intégration de l’analyse et de la conception générique Cartographie des composants Déploiement du poste et des composants d’exploitation (composants distribués, applications, base de données) Interface EAI, intégration de progiciels IHM : vision précise des couches présentation et application Compléter la configuration logicielle Déterminer les modules |

|

Conception détaillée |

Etudier comment réaliser chaque composant Concevoir et documenter le code qui va être produit Processus de construction itératif qui s’applique successivement aux couches logicielles |

|

Codage |

Produire les composants |

|

Tests |

Tester les unités de code Effectuer des tests d’intégration pour tester les IHM |

|

Recette |

Effectuer des tests de recette pour valider les fonctions du système développé |

|

Documentation |

Réaliser la documentation à destination des différents acteurs : utilisateurs, administrateurs et personnes en charge du suivi d’exploitation… |

Diagramme UML dans 2TUP

UML est utilisé pour modéliser le système. Ci-dessous, les diagrammes utilisés durant les différentes phases du processus.

Tableau 4 : Les diagrammes utilisés durant les différentes phases du processus.

|

Phases

Diagrammes |

Capture initiale des besoins |

Capture des besoins techniques |

Capture des besoins fonctionnels |

Analyse |

Conception générique |

Conception préliminaire |

Conception détaillée |

|

Classes |

|

X |

X |

X |

X |

X |

X |

|

Package |

|

X |

X |

|

X |

X |

X |

|

Objets |

|

|

|

|

|

X |

X |

|

Structure composite |

|

|

|

|

|

X |

X |

|

Cas d’utilisation |

|

X |

X |

X |

X |

|

|

|

Séquence |

|

X |

X |

X |

|

X |

X |

|

Collaboration |

X |

X |

X |

|

|

X |

X |

|

Etats |

|

|

|

X |

|

X |

X |

|

De temps |

|

|

|

|

|

X |

X |

|

D’activité |

|

X |

X |

|

|

X |

X |

|

Global d’interaction |

|

X |

X |

X |

|

X |

X |

|

De composants |

|

X |

|

|

X |

|

X |

|

De déploiement |

|

X |

|

|

X |

|

|

XP

L’eXtreme Programming est une alternative à des méthodes plus lourdes dans le cas de projets de taille moyenne [BEN05]. Elle regroupe des bonnes pratiques de développement qui visent à améliorer la qualité des logiciels. Elle repose sur un processus projet en continu. Les phases de conception, de validation et d’intégration sont effectuées en continu. Des itérations sont effectuées au niveau du développement et des livraisons. Le code est sans cesse amélioré par la réécriture. Elle repose sur une rétroaction constante, le pilotage par les tests, une planification par les scénarios clients et l’intégration du client. Elle recherche une conception simple, s’appuie sur des conventions d’écriture et le code produit est une copropriété des membres de l’équipe. Les tests fonctionnels expriment les besoins et permettent d’effectuer la recette de l’application. Cette méthode recherche une meilleure maîtrise de l’environnement en s’inspirant du concept de cible mouvante (moving target).

L’eXtreme Programming repose sur un ensemble de pratiques permettant de réaliser un logiciel, de la programmation à la planification. Cette méthode permet d’organiser l’équipe et de gérer les relations avec le client.

Elle est basée sur des principes qui ne sont pas nouveaux : livraisons fréquentes, relecture de code, tests automatiques.

Mais dans cette méthode, ces pratiques sont poussées à l’extrême.

L’équipe se focalise sur la réalisation et ne perd pas son temps dans des activités imposées consommatrices de temps et de ressources comme la production de documents non exploités.

Le contact humain est positionné au premier rang, dans l’équipe et avec le client.

Il n’existe que très peu de projets pour lesquels les spécifications sont complètes et ne changent pas. Dans cette méthode, on n’attend pas d’avoir l’exhaustivité des spécifications pour commencer à réaliser l’application.

Les modifications des spécifications du client sont acceptées et prises en compte tout au long du projet afin de répondre à ses besoins.

XP définit 13 pratiques classées en 3 catégories :

· les pratiques de programmation

o conception simple (simple design)

o remaniement (refactoring)

o développement piloté par les tests unitaires (unit tests)

o tests de recette (customer tests)

· les pratiques de collaboration

o programmation en binômes (pair programming)

o responsabilité collective du code (collective code)

o règles de codage (coding standards, ownership)

o métaphore (metaphor)

o intégration continue (continuous integration)

· les pratiques de gestion de projet

o livraisons fréquentes (frequent releases)

o planification itérative (planning game : planification effectuée par le client et l’équipe au cours de séances tout au long du projet)

o client sur site (on-site customer, whole team)

o rythme durable (sustainable pace)

Ces pratiques, plutôt d’ordre technique, sont destinées à mettre en place un environnement de travail basé sur les valeurs suivantes :

· la communication pour une meilleure visibilité

la communication directe est favorisée par rapport à l’écrit car elle permet un échange d’informations très important en un minimum de temps.

La documentation n’est cependant pas supprimée, elle est gérée comme un besoin comme un autre. Les différents problèmes rencontrés sont résolus par l’ensemble de l’équipe client et fournisseur.

· la simplicité comme garantie de productivité

· le feedback comme outil de réduction des risques

L’objectif est d’améliorer continuellement le pilotage du projet.

· le courage de prendre de bonnes décisions

Une équipe XP doit remettre sans cesse en question ses méthodes de travail plutôt que de suivre des instructions à la lettre. Les pratiques XP doivent permettre l’amélioration de l’efficacité de l’équipe dans le respect des 4 valeurs d’XP.

Compromis coût, délais, qualité, contenu.

Un projet dépend de 4 variables interdépendantes : coût, délais, qualité, contenu [BEN05].

· Coût

Le fait de changer l’équipe ou l’environnement de travail peut à court terme ralentir l’équipe. La plupart du temps le coût d’un projet est fixé préalablement au lancement du projet, lors de la demande des budgets. Si le coût fixé est sous dimensionné, il y a de fortes chances que la qualité du logiciel en pâtisse. Les coûts de maintenance et d’indisponibilité, quant à eux, risquent d’exploser.

Dans la plupart des cas, la sous estimation du coût d’un projet peut conduire à une dérive conséquente des coûts. La détermination de coûts plus élevés dès le départ permet de limiter l’ampleur des dérapages.

A l’opposé, si le coût du projet est sur dimensionné, on peut être amené à mettre en place une équipe trop importante qui sera difficile à coordonner. Et contrairement à ce que l’on espérait, la qualité de services sera dégradée et la durée du projet allongée.

· Délais

Le fait de repousser les dates de livraison peut induire des coûts de synchronisation et la confiance du client et de l’équipe peut s’en trouver diminuée.

D’autre part, imposer des délais trop courts a pour conséquence de mettre la pression à l’équipe. Le risque est alors un manque de recul des membres de l’équipe et une baisse de leur niveau d’exigence.

· Qualité

Une diminution du niveau de la qualité peut provoquer une démotivation de l’équipe ou une perte de la confiance du client qui finira par s’apercevoir de la dégradation du niveau de qualité. La démotivation de l’équipe peut avoir pour conséquence une augmentation du turn-over.

· Contenu

Cette dernière variable permet d’être très flexible. Il est possible d’adapter le contenu d’un projet en jouant sur le périmètre fonctionnel. La réduction du périmètre fonctionnel permet de conduire à une réduction des coûts, de la durée tout en préservant un niveau de qualité acceptable. C’est sur cette dernière variable que joue la méthode XP.

Equilibre client et fournisseur

Un équilibre doit s’instaurer entre les développeurs et le client.

Le client ne doit pas avoir tous les pouvoirs sinon on tombe dans un projet « marche à mort » (deathmarch projet).

L’équipe ne doit pas avoir trop de pouvoir sinon le projet risque de ne pas répondre aux besoins du client en cherchant à utiliser à tout prix les dernières technologies à la mode.

Dans une organisation XP, les responsabilités sont clairement séparées :

· le client définit les fonctionnalités et leur ordre d’implémentation

· les développeurs estiment les coûts et prennent en charge la réalisation

La mise en œuvre de la méthode XP peut être de chercher à résoudre les problèmes les plus sérieux de manière itérative et de traiter les problèmes restants jusqu’à parvenir à une situation stable.

Influence de la culture d’entreprise

La culture générale de l’entreprise est un facteur important de la réussite d’un projet XP.

Il est difficile de tirer les bénéfices de la méthode XP dans le cas :

· où le mérite se mesure aux heures supplémentaires et où on considère qu’une équipe ne fonctionne à plein rendement que sous forte pression

· d’une culture centrée sur le jeu politique, où les relations de type gagnant / gagnant ne sont pas de mise

· d’une culture attachée aux démarches linéaires où la qualité du logiciel s’exprime en nombre de documents produits.

XP et le cycle en V

Un comparatif simple entre le cycle en V et XP est effectué dans le tableau ci-dessous (Tableau 5).

Tableau 5 : Comparatif simple entre V et XP

|

Points |

V |

XP |

|

Traitement du problème |

De front |

En tranche |

|

Spécification |

Complète |

Partielle. Ajustement des spécifications à partir du feedback du client. |

|

Début de réalisation |

A la fin de la conception |

Tranche par tranche avec prise en compte du changement |

|

Résultat de la conception |

Document |

Code |

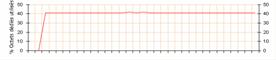

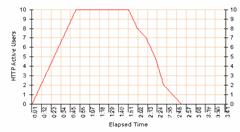

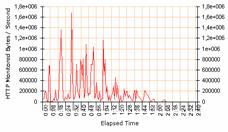

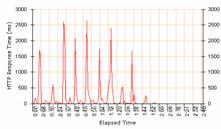

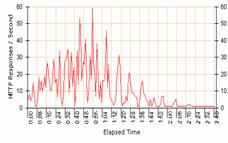

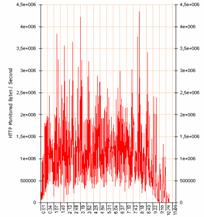

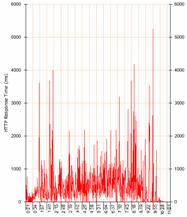

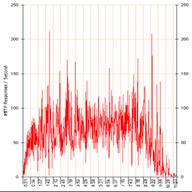

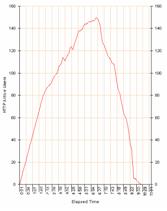

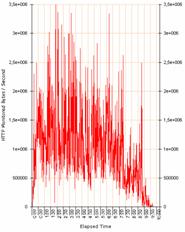

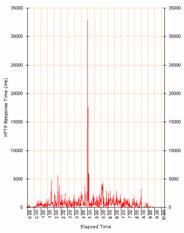

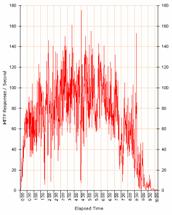

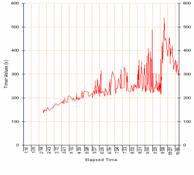

|